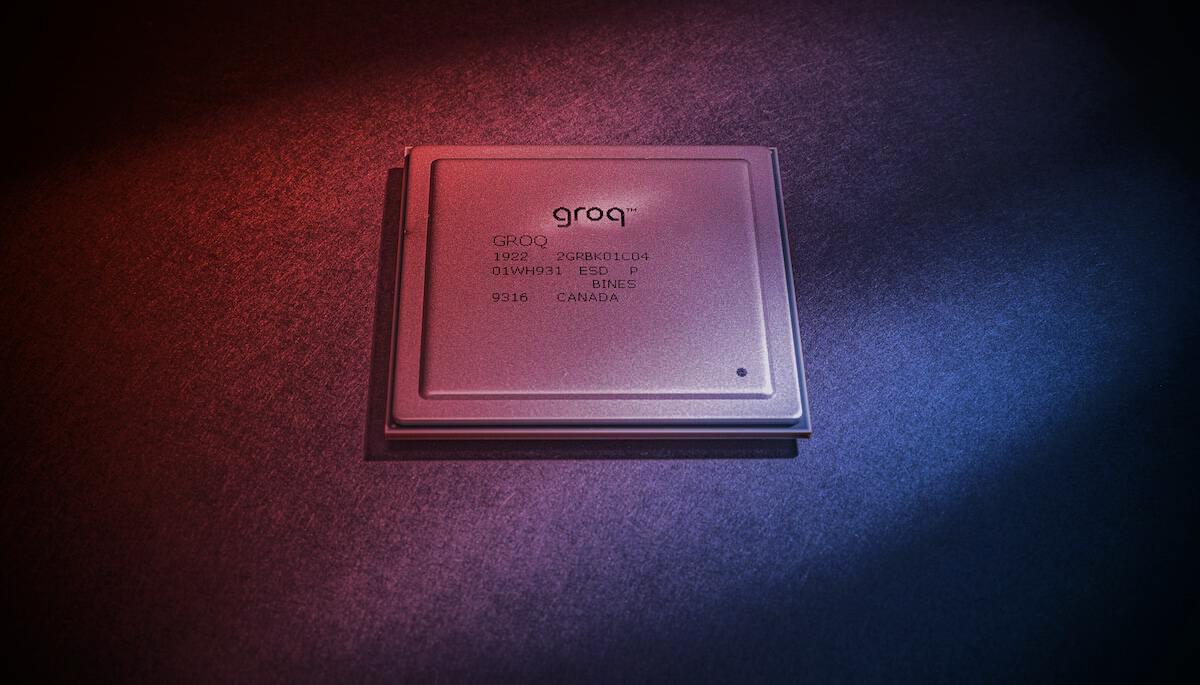

Nem csak licencet, valójában egy komplett céget vettek

Érdemes kiemelni, hogy az Nvidia nem vásárolta meg, hanem hivatalosan csak „nem kizárólagosan” licencelte a Groq szellemi tulajdonát: a nyelvi feldolgozó egységeit (LPU) és a hozzájuk tartozó szoftveres könyvtárakat. Ám a történet bonyolultabb: a Groq vezérigazgatója, Jonathan Ross és elnöke, Sunny Madra, az Nvidiához igazol, magukkal hozva a mérnökcsapat zömét is. Bár Simon Edwards vezetésével papíron marad egy „független” Groq, a kulcsemberek elvándorlása miatt szakértők szerint kérdéses, életben marad-e a cég hosszú távon.

A lépés ezért joggal tűnik olyannak, mint amikor egy cég egyszerűen eltüntet egy riválist. Ugyanakkor felmerül a kérdés, megért-e ennyit a lépés – főleg, mivel még versenyjogi vizsgálatot is kockáztatnak.

A SRAM-forradalom? Valószínűtlen

Sokan gondolják, hogy a vásárlás lényege a Groq LPU-k különleges, úgynevezett SRAM-memóriája. Az SRAM nagyságrendekkel gyorsabb annál a HBM memóriánál, amit például a mostani Nvidia GPU-k használnak: a Groq LPU-kban használt memória akár 10–80-szor gyorsabb, mint az aktuális HBM3e, amely jelenleg 1 TB/s sávszélességet tud modulonként, GPU-nként pedig 8 TB/s-t.

Ezért a Groq chipek elképesztő tempóban generálnak MI-tokeneket: például a Llama 3.3 70B modellen percenként 350 tokent, a GPT-OSS 120B modellen 465 tokent sikerült elérniük. Az elmélet szerint, mivel mindenki szenved a memóriahiánytól, logikus lehetett volna a Groq-ot felvásárolni.

Ám a valóságban az SRAM-nak is súlyos hátrányai vannak. Például térben kevéssé hatékony, így a Groq LPU csak 230 MB memóriát tartalmaz, miközben egy nagy HBM-verem akár 288 GB-ot is elér egy GPU-n (36 GB/verem, 12 verem). Ez azt jelenti, hogy több száz vagy ezer Groq chip kell már egy közepes LLM-hez is. A gyakorlatban például egy Llama 70B futtatásához 574 LPU-ra volt szükség. Ha kellene, az Nvidia maga is tudna hasonló, SRAM-alapú chipeket fejleszteni, tehát csak emiatt biztosan nem vette volna meg a Groq-ot.

Az igazi vonzerő: az adatszalag-architektúra

Úgy tűnik, hogy a fő érték a Groq egyedi „assembly line architecture”-ában, vagyis programozható adatfolyam-architektúrájában rejlik. Ez kifejezetten az MI-következtetések során végzett lineáris algebra számítások gyorsítására épül. A mai processzorok többsége a von Neumann-elv szerint működik: utasítás lefut, adat betölt, eredmény visszaíródik. Az adatfolyam-architektúra viszont folyamatosan a chipeken keresztül „szalagként” áramoltatja az adatokat, lényegében futószalagszerű belső szerkezettel.

A Groq szerint ezzel a chip sosem várakozik a memóriára vagy a számítási egységre, így lényegében megszünteti a GPU-kkal gyakori szűk keresztmetszeteket. Papíron BF16-teljesítményben egy RTX 3090 kártyához, INT8-ban egy L40S-hez hasonlóak a számok, de itt a valósidejű, gyorsabb végrehajtás lehet az igazi különbség.

Érdemes kiemelni, hogy az adatfolyam-architektúra nemcsak az SRAM-ra korlátozott – például a NextSilicon is HBM-mel kombinálja hasonló rendszerét. Tehát az Nvidia minden további nélkül építhet SRAM-, HBM- vagy akár GDDR-memóriás adatfolyam-gyorsítót is a Groq szabadalmaira támaszkodva.

Mire jó akkor mindez az Nvidiának?

A nagy MI-modellek következtetését egyre nehezebb tovább gyorsítani, minden cég igyekszik új utakat találni. Az Nvidia eddigi inference-optimalizált architektúrái (például a H200 vagy B300) csak gyorsabb vagy nagyobb memóriával rendelkező testvérei voltak a mainstream chipeknek, érdemi strukturális különbség nélkül.

A Rubin-generációval azonban 2026-ra érkeznek az első, kifejezetten inference-feladatokra optimalizált chipek. Az elképzelés szerint a Rubin-széria a számításigényes „prefill” szakaszra, a Vera Rubin nevű chipek pedig a memóriasávszélesség-igényes dekódolásra optimalizálnak, így minimalizálják az erőforrások közötti konfliktust.

A Groq chipjei csak szerény mennyiségű SRAM-ot tartalmaznak, ezért önálló dekódoló gyorsítónak nem ideálisak, de a spekulatív dekódolásnál érdekesek lehetnek. Ez egy olyan technika, ahol egy kis „vázlatmodell” előrefut, és ha a predikciója pontos, a rendszer akár duplázza vagy triplázza a sebességet, csökkentve az egy tokenre vetített költséget.

A Groq chipek pont ilyen kis modellekhez elegendőek, így nem kizárt, hogy az Nvidia ezen a téren hoz ki belőlük valami újat.

Nincs extra gyártókapacitás, csak hosszú távú stratégia?

Felvetődött, hogy az Nvidia talán a gyártókapacitások (Samsung, GlobalFoundries) miatt vette volna a Groq-ot. Ez azonban tévút, hiszen az Nvidia eddig is gyártatott a Samsunggal: például az Ampere GPU-k többségét is ők gyártották. Az igazi ok minden bizonnyal nem itt keresendő.

Úgy tűnik, hogy az Nvidia hosszabb távon gondolkodik; lehet, hogy a Groq jelenlegi chipjeivel nem csinál semmit, hanem inkább a know-how-t és a mérnökcsapatot akarta megszerezni, hogy a jövő MI-chipjeibe beépíthesse ezeket az új architektúrákat.

Ez az összeg, 20 milliárd dollár, első ránézésre óriási, de az Nvidia számára csak egyetlen negyedévnyi működési cashflow-ja; az MI-piac jelenlegi tempóját tekintve a gyors fejlesztés és a jövő technológiájához vezető rövidebb útvonal simán érhet ennyit.