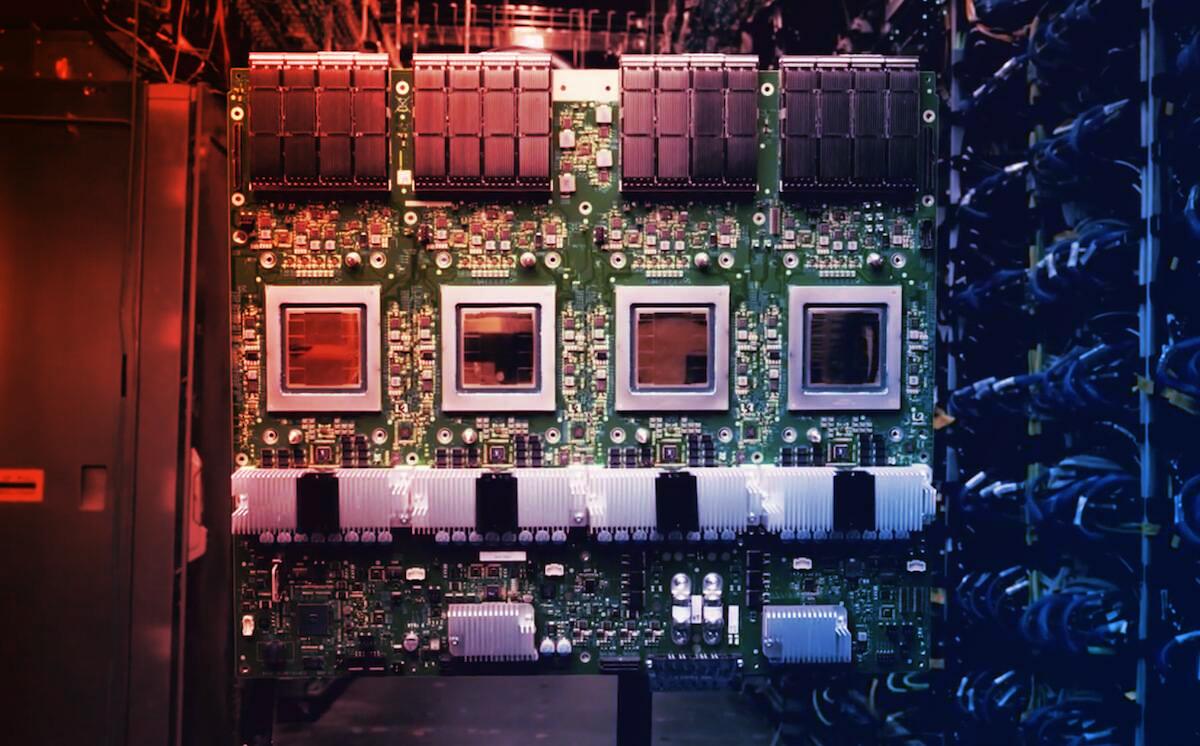

Az Ironwood ereje: Rekordok és összehasonlítások

Az Ironwood, hivatalos nevén TPU v7, darabonként 4,6 petaFLOPS FP8 teljesítményt produkál, ami kicsivel több, mint az Nvidia B200-as GPU-ja (4,5 petaFLOPS), és csak kis mértékben marad el a GB200, illetve GB300 szintjétől (5 petaFLOPS). Minden Ironwood chiphez 192 GB HBM3e memória jár, 7,4 TB/s sávszélességgel – összehasonlításképpen az Nvidia B200 192 GB HBM-et és 8 TB/s-ot tud.

A chipek közötti kommunikációt négy ICI Link biztosítja, 9,6 Tbps összesített duplex sávszélességgel, míg a rivális Nvidia B200/B300 modellek 14,4 Tbps (1,8 TB/s) sebességgel kommunikálnak egymással. Ettől függetlenül az Ironwood eddig a Google legerősebb TPU-ja: tízszer gyorsabb, mint az előző TPU v5p modell, és négyszerese a tavaly bemutatott TPU v6e (Trillium) teljesítményének. Szinte egy szinten áll az Nvidia és az AMD új generációs chipjeivel.

A méret számít: Skálázhatóság gigászi léptékben

A Google igazi előnye a nagy léptékű, könnyen skálázható rendszerekben rejlik. Míg az Nvidia NVL72 rendszere 72 Blackwell-gyorsítót egyesít egyetlen számítási egységként, a Google Ironwood chipeket már 256-tól akár 9 216-ig terjedő podokban kínálja. Akinek ez sem elég, további podokat kapcsolhat össze. A Google Jupiter adatközponti hálózata elméletben akár 43 ilyen pod összekapcsolását is támogatja, ez körülbelül 400 000 gyorsítót jelent egyetlen klaszteren belül.

Mindez azt mutatja, hogy a Google bámulatosan nagy rendszerigényeket is ki tud szolgálni: korábban is megszokottak voltak a több tízezer chipes Nvidia-rendszerek, de most a Google podjai nagyságrendekkel nagyobb egységeket kínálnak.

Egyedi hálózati architektúrák: Torusz és OCS

Az Nvidia nagy, lapos kapcsolási topológiákat használ az adatközponti rendszereiben, míg a Google háromdimenziós torusz hálózatot alkalmaz. Ebben minden chip másikhoz csatlakozik, mintha egy háromdimenziós hálót alkotnának. Így nincs szükség nagy, energiaigényes csomagkapcsolókra, amelyek késleltetést adnak hozzá a rendszerhez. Helyettük optikai áramkörkapcsolókat (OCS) alkalmaznak, amelyek fizikailag kapcsolnak össze két portot, ezzel közel nullára csökkentik a késleltetést, és ha egy chip meghibásodik, egyszerűen kiváltható egy másikkal. Ez növeli a hibatűrést és a rendszer stabilitását is.

Meg kell jegyezni, hogy az OCS alkalmazása közel tíz éve megjelent, de igazán most teljesedik ki az MI-számítások világában.

A nagy MI-piac szereplői már sorban állnak

Nem véletlen, hogy a legtöbb vezető MI-modellfejlesztő, például az Anthropic is, már lecserélte vagy kiegészítette rendszereit a Google TPU-kkal. Az Anthropic akár egymillió Google TPU-t is igénybe venne következő, Claude nevű modelljeihez, miközben az Amazon Trainium 2 gyorsítóival is dolgozik – ezek szintén torusz-hálózatokra építenek.

A szoftveres ökoszisztéma még sokszor az Nvidia felé billenti a mérleget, de a hardverelőnyök egyre egyértelműbbé válnak. Az MI-háborúban tehát a Google és az Amazon gyorsan zárkózik fel, miközben a skálázhatóság, a rugalmasság és a teljesítmény új dimenziója nyílt meg a felhasználók előtt.

Különösen fontos kiemelni, hogy az MI-hardverek közötti verseny már nemcsak a puszta számítási teljesítményről, hanem a méretben, a hálózatban, a skálázhatóságban és az energiahatékonyságban mutatkozó különbségekről is szól. A Google Ironwood TPU-ja most egyértelműen új mércét állít.