Miért bukik el az MI a memórián?

A transformer-alapú nyelvi modellek minden egyes feldolgozott token kontextusát egy KV-cache-ben tárolják. Minél nagyobb a párbeszéd vagy a feldolgozandó anyag, annál több memóriát igényel ez a gyorsítótár. Egyetlen 100 000-tokenes szekvencia akár 40 GB GPU-memóriát igényelhet, miközben a legerősebb grafikus kártyák is csak 288 GB HBM-mel rendelkeznek, amelyben azonban a modell is helyet foglal.

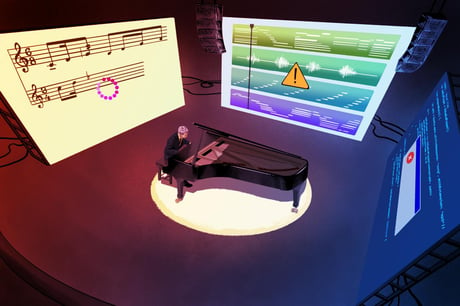

Valós környezetben – például többfelhasználós rendszerekben, ahol forráskódot fejlesztenek vagy adóbevallásokat dolgoznak fel – a gyorsítótár kihasználása gyorsan eléri a maximumot. Három vagy négy nagyobb PDF betöltése után a KV-cache máris megtelik, és kénytelen eldobni régi adatokat. Az MI-rendszer így elveszíti a kontextus folytonosságát, nem képes tartós emlékezetet fenntartani.

Az elrejtett költség: az újraszámolási adó

A GPU-k egyre gyakrabban számolnak újra már egyszer elvégzett műveleteket: feltöltik a gyorsítótárat, dekódolnak, kifogynak a tárból, törlik a régi adatokat – majd kezdődik elölről az egész. Ezzel akár 40 százalékos felesleges energia- és számítási igényt generálnak, ami komolyan drágítja az MI-alapú szolgáltatásokat.

A szolgáltatók ezért már arra tanítják a felhasználóikat, hogy a promptjaikat úgy építsék fel, hogy lehetőleg elérjék azt a GPU-t, amelyben már megtalálható a szükséges gyorsítótárazott információ – így kihagyható az időigényes előtöltési fázis, és a rendszer gyorsabban válaszolhat. Ezt követően viszont a probléma lényege – a GPU-memória véges volta – továbbra is megmarad.

Áttörés: a tokenraktározás és a bővített memória

A helyzet megoldásához több út kínálkozik. Egyes cégek a modellek egyszerűsítésével próbálnak takarékoskodni a gyorsítótár által igényelt hellyel, mások a gyorsítótár-hatékonyságot növelik. Gyakori megoldás, hogy a KV-cache-t egy GPU állítja elő, majd megosztják, vagy helyi szerveren tárolják tovább.

A WEKA azonban egy teljesen új szemléletet hoz az Augmented Memory és a token warehousing (tokenraktározás) bevezetésével. Itt a kulcs–érték-gyorsítótár nemcsak a GPU-memóriában, hanem egy gyors, közös raktárban, az úgynevezett NeuralMesh architektúrán belül él tovább. Így a memória már nem szűk keresztmetszet, hanem rugalmasan bővíthető erőforrás lesz – mindezt várakozás vagy többletkésleltetés nélkül.

Ennek eredményeként a cache-találati arány 96–99% is lehet, a GPU-kon előállított tokenek száma pedig 4,2-szeresére nőhet. Vagyis 100 GPU olyan teljesítményt érhet el, mintha 420 GPU dolgozna egyszerre. Következésképpen hatalmas költségcsökkentés is lehetséges: néhány nagyobb szolgáltatónál napi több százmillió forintnyi megtakarítást eredményezhet ez a bővítés.

A folytatás még ennél is izgalmasabb

Az NVIDIA szerint az elkövetkező években akár százszorosára nőhet az MI-inferencia iránti igény. Ez már most leszivárog a legnagyobb szolgáltatóktól a hétköznapi vállalati rendszerekig. Ezt követően azok a cégek kerülnek előnybe, amelyek stratégiai fontosságúnak tekintik a memóriakezelést: költséghatékonyabbak lesznek, miközben javul a szolgáltatás minősége.

A memóriafal tehát nem pénzkérdés – az MI világában ez az első olyan infrastrukturális korlát, amely alapvető szemléletváltásra kényszeríti a piacot. Az elkövetkező MI-forradalom egyik döntő ütközete minden bizonnyal itt, a memóriakezelésben dől el.