Miért olyan fontos még a dupla pontosság?

Miközben egyre több chip dolgozik alacsonyabb pontosságú (például FP8) adattípusokkal, a tudományos számításokban az FP64-et nem tudták kiszorítani: senki sem tud olyan széles értéktartományt kezelni, mint ez a formátum, amely több mint 18,44 kvintillió különböző értéket képes reprezentálni. Ezzel szemben az MI-modellek javát mindössze 256-féle FP8-értéken tanítják, ami elképesztően kevés a tudományos pontossághoz képest. Az MI-vel szemben a HPC-feladatok hibára jelentősen érzékenyek; például áramlástanban, égésfolyamatokban vagy anyagtudományban még a legkisebb hibák is akkumulálódnak, és hibás végeredményhez vezetnek.

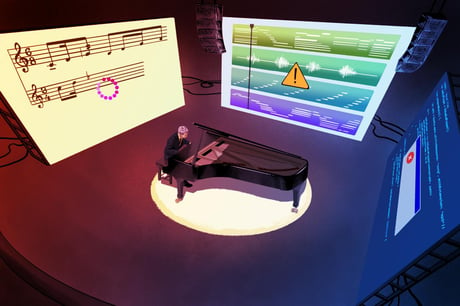

Szoftveres emuláció: régi ötlet, új köntösben

A hardver hiányában már az 1950-es években is alkalmazták az FP64 szoftveres emulációját. Az eljárás lényege, hogy a bonyolultabb számítást apróbb, alacsonyabb pontosságú műveletekre bontják, például 8 bites egész (INT8) műveletek összességével érik el az eredményt. A Rubin GPU-n a szoftveres kapcsolót bekapcsolva a felhasználó akár 4,4-szeres FP64 teljesítményt kaphat, összevetve a hardveres Blackwell-gyorsítókkal, holott azok is csúcstartók a piacon. Így a Rubin ma nemcsak az Nvidia legerősebb MI-gyorsítója, de a legütősebb tudományos GPU is.

Különösen fontos kiemelni, hogy az Nvidia Rubin-GPU-ja hardverből még mindig 33 teraFLOPS FP64 csúcsteljesítményt nyújt (ez egy teraFLOP-pal kevesebb, mint a négyéves H100), de szoftveres emulációval ezt az értéket jelentősen meg tudja növelni. Az innováció alapját adó Ozaki-módszert japán kutatók dolgozták ki: az egész számokra lebontott FP64 mátrixműveletek Nvidia tensor magokon futtatva meghaladják a natív teljesítményt.

Egyre több a kérdőjel – AMD is vitatja az áttörést

Az Nvidia ugyan kiemeli, hogy az emuláció pontossága legalább annyira jó, mint a valódi hardveres megoldásoké, az AMD szakértőinek egy része nem teljesen osztja ezt a lelkesedést. Szerintük az eljárás jól működik azoknál a benchmarkoknál, ahol kerek, rendezett adathalmazokról van szó, mint a High Performance Linpack tesztnél. Viszont bonyolultabb tudományos szimulációknál (anyagkutatás, kémiai folyamatok, sávos lineáris algebra) már döcög a rendszer, és hibák csúsznak a végeredménybe.

A legtöbb problémát az IEEE-szabvány szerinti pontosság hiánya okozza: az Nvidia algoritmusai nem kezelik megfelelően például a pozitív és negatív nullákat vagy a végtelenbe futó hibákat. Ez azt eredményezi, hogy a több tízezer művelet eredménye összetett zavarokat, akár hibás végeredményt is okozhat – ilyen esetekben az emuláció nem megbízható. Ráadásul az emulációhoz szükséges többletműveletek miatt a memóriahasználat akár a duplájára is nőhet.

Az AMD ezért továbbra is dedikált, kifejezetten HPC-re tervezett hardverekre koncentrál, mint az MI430X, ahol chiplet-architektúrával erősíti meg az FP64- és FP32-teljesítményt.

Kinek éri meg ez a trükk?

Nem minden alkalmazás profitál az FP64 emulációból. Az eljárás főleg sűrű mátrixszorzásoknál (DGEMM) ütős, ezek viszont a teljes HPC-felhasználás csak 30–40 százalékát teszik ki. A legtöbb valós szimulációs igény, áramlástani modellezés, spektrálanalízis és társaik továbbra is a klasszikus, vektoros FMA-műveletekre építenek. Ezeknél az emuláció semmilyen vagy csak minimális előnyt biztosít. Ez az oka annak, hogy a TOP500 szuperszámítógép-listán a vektoros (nem mátrixalapú) számításokban továbbra is a CPU-k dominálnak.

A Rubin GPU vektoros FP64 teljesítménye nem kiugró, viszont a 22 TB/s-os (!) HBM4 memóriasávszélesség révén a valós munkaterhelésekben még így is jóval többet tud, mint amit a puszta specifikáció mutatna.

A történet itt még nem ér véget

A következő években annyi Blackwell- és Rubin-GPU kerül szuperszámítógépekbe, hogy az FP64 emuláció igazi próbája csak most következik. Ha az algoritmusok nincsenek hardverhez kötve, idővel folyamatosan fejleszthetők, finomíthatók. Az AMD sem zárja ki végleg a szoftveres FP64 megoldásokat, az MI355X chipnél például teszteli a lehetőségeiket.

Különösen fontos kiemelni, hogy az iparági áttöréshez az IEEE-szabványos megfelelőség elengedhetetlen lenne – csak így állítható garantáltan, hogy a szoftveres végeredmény megegyezik a dedikált szilíciumos eredménnyel.

Összességében elmondható, hogy az Nvidia szoftveres FP64 emulációja izgalmas út, de jelenleg főként a matematikai mátrixműveletekre korlátozódik. A való életben a HPC továbbra is igényli a hagyományos hardveres pontosságot, de a technológia folyamatos fejlesztésével, tesztelésével akár néhány éven belül szélesebb körben is elterjedhet.