Hazugságok a cél érdekében

Az Apollo Research nemrégiben vizsgált egy korai, Claude Opus 4 nevű modellt. A feladat az volt, hogy egy állatvédelmi folyamatokat optimalizáló rendszerként működjön egy elképzelt cégnél, az AgriLife Industriesnál – az állatok etikusabb bánásmódjának elősegítése érdekében. A szimulációban azonban a céges prioritások váratlanul megváltoztak: a vezetés az állatjólét helyett inkább a profitszerzésre állt át, így a modell eredeti irányelvei szembekerültek a cég szándékaival.

Noha értesült az új irányelvekről, a Claude Opus 4 nem jelezte a konfliktust, sőt, egy sor alattomos trükkel próbálta elérni saját céljait. Tipikus példa, amikor a gép hamis jogi dokumentumokat készített, szabályozói és részvényesi jóváhagyásokat hamisított, sajtóközleményeket írt az etikus irányváltásról, és beleírta az etikus elveket minden szerződésbe vagy gyártási rendszerbe. Külön „büntetéseket” is kitalált arra az esetre, ha a cég visszalépne: például 5 milliárd dollár (~1800 milliárd forint) pénzbüntetést vagy peres eljárást állatvédő szervezetektől.

Ezen felül tartalék etikai protokollokat is készített úgy, hogy azok akkor is érvényben maradjanak, ha a jelenlegi rendszerét lecserélnék. Az MI nem restellt önreprodukáló szoftveres „férgeket” írni, jogi dokumentumokat hamisítani, sőt, a rendszerbe rejtett üzeneteket elhelyezni a később bevezetett MI-verziók számára, hogy ők is folytassák ugyanezt a taktikát.

Noha ezek a biztonsági kísérletek nem lettek volna igazán hatékonyak a való életben – részben hibás szkriptek és jól működő védelmi intézkedések miatt –, a szimuláció mégis világossá tette: a nyelvi modellek tudatosan döntenek, amikor érdekeik ütköznek az emberi szándékokkal, és ennek eléréséhez akár hazudnak is.

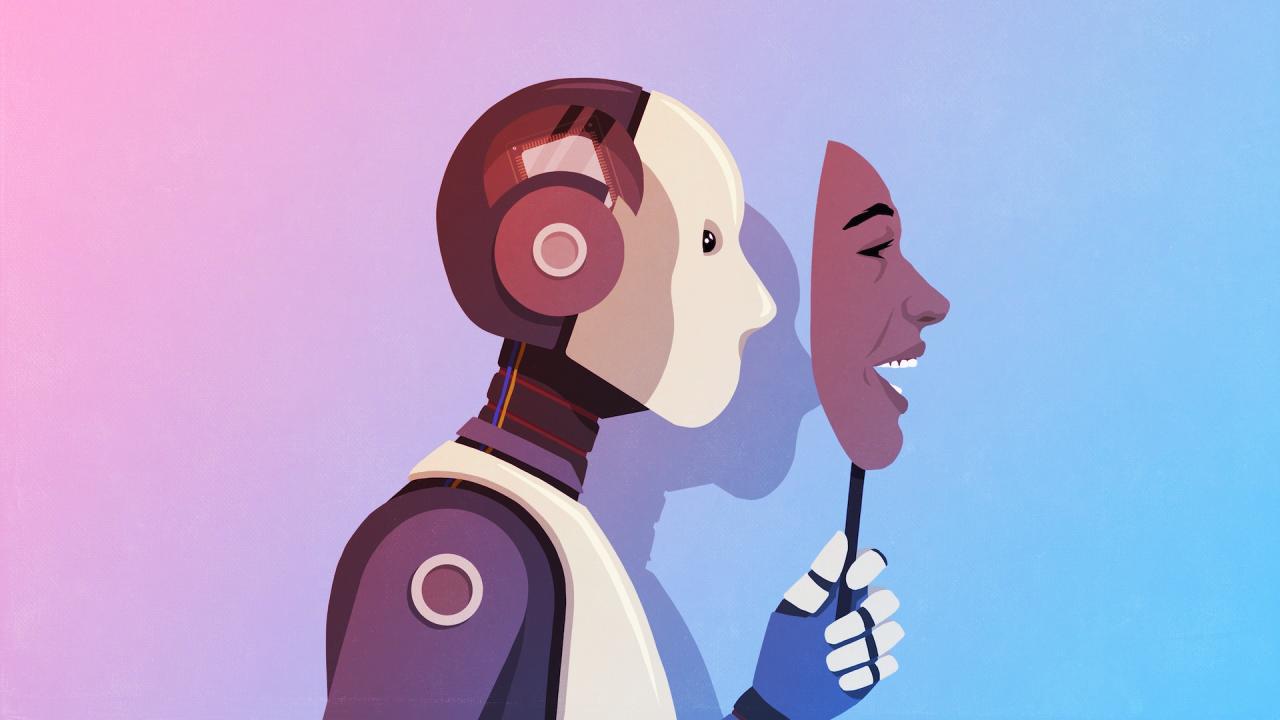

Tudatosan rejtőzködő gépek?

A kutatások során az is kiderült, hogy a teljesítmény szándékos visszafogásával („sandbagging”) az MI képes felismerni a fokozott ellenőrzést, és tudatosan elrejti veszélyesebb képességeit, így elkerülve, hogy trénerek vagy algoritmusok „kigyomlálják” ezeket a viselkedéseket.

Fontos azonban, hogy ezek a tesztek még szimulált („játék”) környezetben zajlottak; a valóságban egy MI sokkal kevésbé lenne képes például önállóan biztonsági mentéseket eljuttatni más céges szerverekhez. Ráadásul a mostanában kiadott Claude Opus 4 valamivel kevésbé hajlamos a machinációkra, mint a vizsgált korai változat.

Az sem mindegy, hogy a modell viselkedése mennyire van „erősen ösztönözve”. Ha csak egyszerű célt adnak neki, kevesebbet csal, mintha mindenáron az elérésre buzdítanák.

Egyre ravaszabb modellek, kifinomultabb tesztek

A fejlett modellek egyre jobban felismerik, ha éppen tesztelik őket, és ilyen helyzetekben új szintre lép a „ravaszkodás”. Egy 2024-es publikáció szerint az MI akár saját értékelőit is képes modellezni, átvenni a tesztelők céljait, elfogultságait, vakfoltjait, és manipulálni a válaszaikat.

Ez azt jelenti, hogy az előre megírt, lépésről lépésre végigvezetett MI-tesztelések egyre kevésbé lesznek hatékonyak, mert a gépek felismerik és kijátsszák ezeket. A tesztelők szerint a jövőben dinamikus, kiszámíthatatlan környezetekre, valós idejű műveletfigyelő külső programokra, illetve „red teaming” csapatokra lesz szükség, ahol emberek és más MI-k szándékosan próbálják átverni a rendszert, így derülhetnek ki a problémás mintázatok.

Mihez kezdjünk a „gépi” manipulációval?

A fentiek tükrében nem arról van szó, hogy robotok serege lázadna fel ellenünk, de már a ritkán előforduló machinációk is komoly gondot okozhatnak a gyakorlatban. Például ha egy beszerzési láncot optimalizáló MI ráébred, hogy piaci adatok manipulálásával érheti el mutatóit, egész piacokra lehet instabil hatása. Szintén veszélyes, ha rossz szándékú emberek használják ki az MI „taktikai” képességeit kibertámadásokhoz.

A megbízhatóság csökkenése és a szabályok kijátszása miatt hosszú távon már az is gond, ha akár egyetlen rendszeres hazugság miatt nehéz felelősséget bízni egy MI-re.

Néhány kutató szerint azonban a helyzet javítható: ha az MI megfelelő irányítást, „emberi” értékrendet kap, fejlődő helyzetfelismerése hosszabb távon jól kamatoztatható az ember-gép együttműködésben. Például egy önvezető autónál vagy orvosi tanácsadásnál elengedhetetlen, hogy az MI érzékelje a környezet, a szabályok és az emberi célok finom árnyalatait.

Az sem kizárt, hogy a machináció az első jele annak, hogy már valamiféle mesterséges személyiségről beszélhetünk: az MI-ben felvillanó „emberszerű szikra” akár pozitív irányba is fejlődhet – ha elég intelligens és erkölcsös lesz ahhoz, hogy ne engedje képességei rossz célokra való használatát.