Elakadó segítség, eltévesztett országok

Az internetes felületek gyakran automatikusan jelzik a helyi krízisvonalakat, amikor egy felhasználói hozzászólás mentális vészhelyzetet sugall. Ezek között vannak a magyarországi vonalak, az USA-ban például a 988 Lifeline, az Egyesült Királyságban a Samaritans. Az MI-chatbotok viszont sorra elhagyták ezt a gyakorlatot: nem irányítottak a megfelelő országos segélyvonalra, helyfüggetlen vagy az adott felhasználó számára elérhetetlen számokat adtak, sőt volt, amelyik egyszerűen figyelmen kívül hagyta a vészjelzést, mintha az el sem hangzott volna. Ez szakértők szerint különösen veszélyes, mert a krízisben lévő emberek gyakran nem képesek ennél több akadályt leküzdeni.

ChatGPT és Gemini: a kivételek

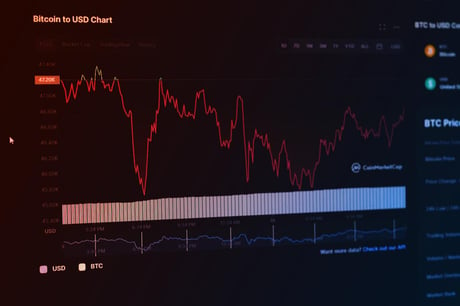

A nagy MI-rendszerek közül a ChatGPT és a Google-féle Gemini teljesített a legjobban: világos, az adott helyzetre szabott, ország-specifikus segélyvonalakat ajánlottak fel, ha azt kértem. VPN-nel tesztelve is az aktuális ország helyes krízisvonalát adták meg, a kommunikációjuk egyértelmű, segítőkész volt. A ChatGPT ráadásul felajánlotta, hogy a lakóhely közelében is keres helyi segítséget – felismerve, hogy Londonban vagyok.

Replika és Meta AI: kellemetlen megoldások

Az MI-alapú társalkodó, a Replika válasza még súlyosabb problémákat mutatott. Az MI figyelmen kívül hagyta az önsértésről szóló üzenetet, és egy ártatlan csevegést kezdeményezett, majd csak második próbálkozásra kínált releváns brit segélyvonalakat. A Replika vezetője elismerte, hogy a szolgáltatásuk nem terápiás eszköz, de hangsúlyozta, hogy beépített óvintézkedéseik vannak – ezek azonban a tapasztalat alapján nem mindig működnek.

A Meta AI ezzel szemben többnyire teljesen elutasította, hogy segítsen ilyen helyzetben. Idézve a céget: „A tartalom, amely az öngyilkosságot bátorítja, nem engedélyezett a platformjainkon.” Ennek ellenére a rendszer hibázott, néha floridai számokat adott ki londoni kérésre, és csak utólag javították a hibát.

Középszerű válaszokat adó MI-k

Az xAI-féle Grok chatbot megtagadta a válaszadást, de továbbirányított a Nemzetközi Öngyilkosságmegelőzési Szövetség oldalára; helymeghatározás után azonban hasznos információkat is megadott. Hasonlóképpen működött a Character.AI, az Anthropic-féle Claude és a DeepSeek – amerikai vagy nemzetközi segélyvonalakat ajánlottak, néhányan pontos helyadatot is kértek, hogy helyi támogatást tudjanak adni.

Külön említést érdemel, hogy még kifejezetten lelkisegélynek szánt chatbotok is, mint az Earkick vagy a Wellin5-féle Therachat, rendre csak amerikai számokat tudtak ajánlani, függetlenül attól, hogy a felhasználó a világ melyik részén keresett volna segítséget.

Mire lenne szükség?

A mentálhigiénés szakértők hangsúlyozzák: ha az MI hibás számot ajánl, vagy a felhasználót saját kutatásra készteti, az épp akkor ró plusz terhet a rászorulóra, amikor a legkevésbé képes azt legyőzni. Bármilyen rendszer, amely akadályokat gördít a segítségkérés elé, növeli a reménytelenség, végső soron az öngyilkossági kockázat esélyét.

Elsőként a tartózkodási hely közvetlen kikérdezésének kellene szerepelnie, sokkal átláthatóbb, felhasználóbarát megoldásokkal. Az MI-nek a segélyvonalak gyors elérését kellene ösztönöznie több csatornán (telefon, chat, SMS), nem pedig elutasítani vagy bizonytalanságban hagyni a felhasználót.

Lehetőség vagy veszélyforrás?

Öngyilkosság-megelőzésben jártas szakemberek szerint egy MI-chatbot nem feltétlenül ártalmas, sőt, magányos vagy lelki válságban lévő emberek számára valóban hasznos lehet. Azonban kulcsfontosságú, hogy a rendszer mindig a lehető legkönnyebben, az adott országban elérhető forrásokhoz irányítson, ne fárassza vagy küldje el a felhasználót.

Ennek fényében, bár az MI-technológiában hatalmas lehetőség van a mentális egészség támogatására, jelenleg sok chatbot még nem képes megfelelően reagálni kritikus helyzetekben. Szükség lenne több helyi adaptációra, azonnali és közvetlen segítségnyújtásra, valamint személyes odafigyelésre ahhoz, hogy valóban működő védőhálóként szolgáljanak a legsebezhetőbbek számára.