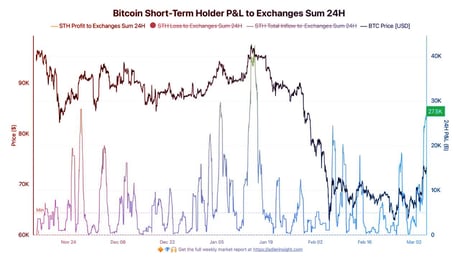

Nincs egy helyes válasz: a konvergencia veszélyei

Noha a helyesség sokáig elsődleges értékelési szempont volt az MI-rendszereknél, egyre inkább igaz, hogy a kreatív, ötletelő vagy nyitott végű feladatoknál valójában a válaszok sokszínűsége a kulcs. Különösen igaz ez akkor, ha a modellek ugyanarra a „biztonságos” válaszra hajlanak, elnyomva a kreativitást. Az Infinity-Chat benchmark képes mérni a modellek önismétlő válaszait, illetve azt, mennyire gondolkodnak hasonlóan más modellekhez képest. Részletesebben: kiderült, hogy a különböző architektúrák egyre inkább egységes válaszokat adnak, még akkor is, ha több helyes megoldás létezik. Ez céges környezetben is nehézségeket okozhat, hiszen a túlzottan biztonságos, egyforma asszisztensek elveszítik kreatív értéküket.

A figyelem még nem tökéletes – egy apró változtatás nagyot dob a teljesítményen

A transzformerek figyelmi mechanizmusa stabilnak hitt elem volt, de egy kutatásból kiderült, hogy egy egyszerű, lekérdezésfüggő „kapu” (szigmoid gate) alkalmazása jelentős fejlesztést eredményezhet. Ezzel növekszik a stabilitás, javul a hosszú szövegek kezelése, és csökkennek a tipikus figyelmi hibák. A trükk lényege, hogy a kimenetet a nemlinearitás gazdagabbá teszi, és kordában tartja az aktivációk szükségtelen burjánzását. Ez azt sugallja, hogy a megbízhatóság hiányának oka gyakran szerkezeti, és nem csak matematikai.

Megerősítéses tanulás: a mélység kritikus tényező

Sokan gondolják, hogy az RL rosszul skálázódik, ha nincs elegendő visszacsatolás vagy bemutató adat. Noha ez részben igaz, kiderült, hogy ha a hálózatok rétegszámát tízszeresére növeljük (akár 1000 rétegre), az önfelügyelt tanulás 2–50-szer jobb eredményt érhet el. Ehhez azonban szükség van kontrasztív célokra, stabil optimalizálásra és célorientált reprezentációkra is. Ez az autonóm ügynökök és folyamatok számára is fontos lehet: a háló mélysége a kulcs a valódi általánosításban és felfedezésben, nem csupán az adat vagy a visszajelzés mértéke.

A diffúziós modellek: miért nem csak memorizálnak?

A diffúziós modellek hatalmas paraméterszáma ellenére nem esnek automatikusan a túlillesztés áldozatául. A kutatók kimutatták: a tanulás elején gyorsan nő az általánosító képesség, míg a memorizálás csak később, lassabban indul. A memorizáció üteme lineárisan nő az adathalmaz méretével, így a modell egyre tovább fejlődhet túlillesztés nélkül. Ennek gyakorlati hozadéka, hogy a túl korai leállítás helyett célszerű az adathalmaz méretét okosan növelni, így késleltethető a memorizáció, és jobb minőség érhető el.

Az RL a meglévő gondolkodást javítja, de nem hoz újat

Sokan remélik, hogy az RL képes teljesen új gondolkodásmódokat megtanítani a nyelvi modelleknek (LLM-eknek). A valóság azonban az, hogy az RL elsősorban a mintavételezés hatékonyságát javítja, a gondolkodás kapacitását viszont kevésbé bővíti. Nagy mintaméretnél az alapmodellek válaszai már gyakran tartalmazzák a helyes gondolkodási láncot. Ebből az következik, hogy ha valódi előrelépést várunk a gondolkodásban, az RL-t más mechanizmusokkal, például tanári disztillációval vagy szerkezeti újításokkal kell ötvözni.

A fejlődés valódi korlátja: rendszertervezés

Az új eredmények egyértelmű üzenete: az MI már nem attól lesz jobb, hogy mekkora a modell, hanem attól, ki érti jobban az egész rendszert. A diverzitás elvesztése új mérőszámokat követel, a figyelmi hibákat szerkezeti változtatásokkal, az RL korlátait a mélység növelésével lehet átlépni, a memorizáció pedig késleltethető okos tanítási dinamikával. Az előny már nem a legnagyobb modelleké, hanem azoké, akik átlátják a teljes rendszert.