Az agyi aktivitásból értelmes leírások

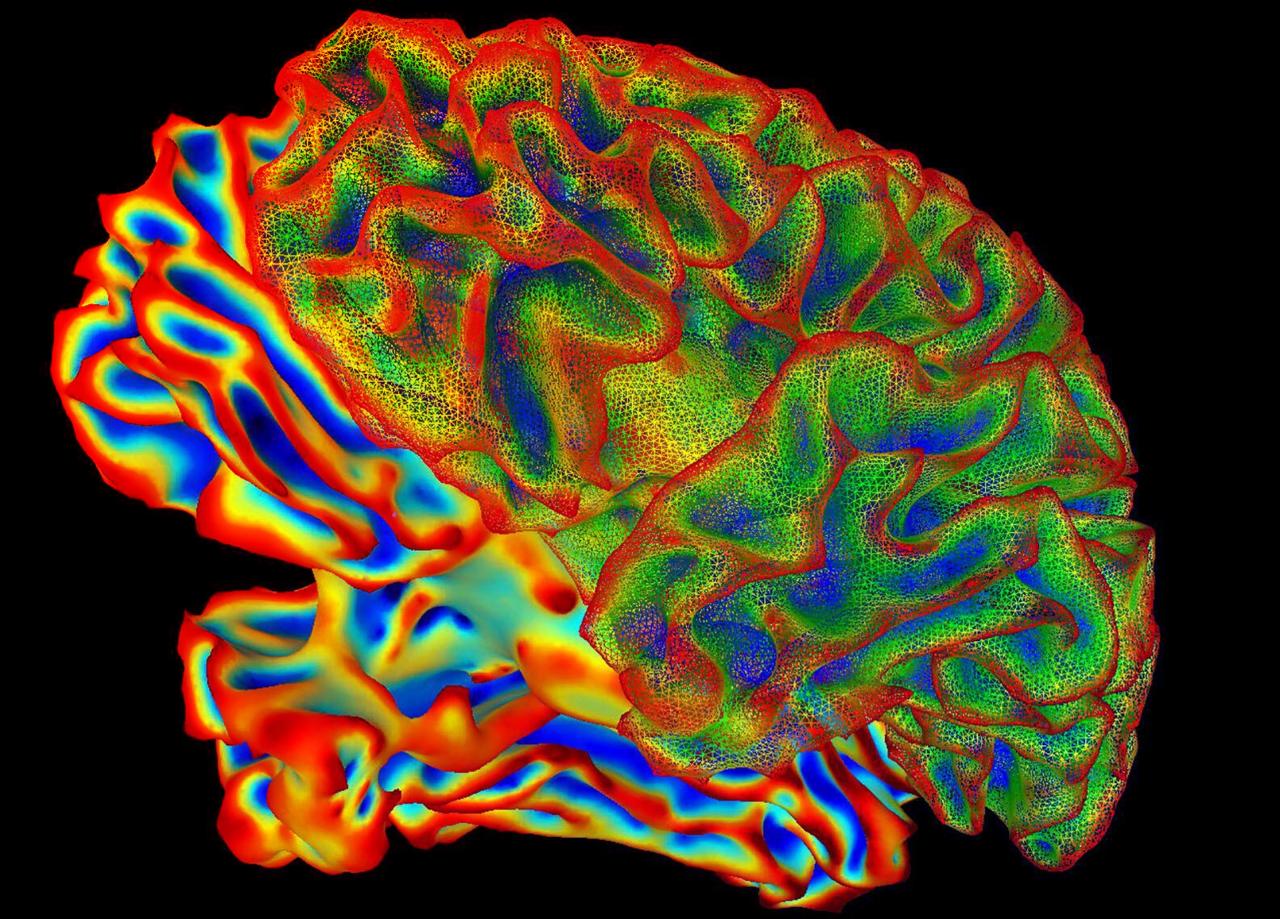

A kutatók egy mélytanuláson alapuló MI-t alkalmaztak, amely több mint 2 000 videó feliratát elemezte, és ezekből egyedi jelentésjegyeket (meaning signatures) generált. Ezután hat résztvevő agyi aktivitását vizsgálták funkcionális MRI-vel, miközben videókat néztek. Az MI-t megtanították felismerni, hogy mely agyi mintázatok mely jelentésjegyeknek felelnek meg.

A rendszer alkalmazásakor egy új videórészlet nézése közben készült agyi mintázat alapján az MI először tágabb, majd lépésről lépésre egyre pontosabb mondatokat generál: például egy vízesésről leugró embert látva először csak annyit talál, hogy „zuhogó víz”, majd végül odáig jut, hogy „valaki egy magas vízesés fölött ugrik le egy hegygerincen”.

Látott és felidézett képek dekódolása

Jelentős, hogy a fejlesztők azt is kipróbálták, mennyire működik a módszer, ha a résztvevők nem néznek ténylegesen filmet, hanem csak felidéznek egy klipet. Az MI ilyenkor is sikeresen generált szöveges leírást, vagyis az agy a látott és az elraktározott információt hasonló módon kódolja.

Mi várható a jövőben?

Az új módszer nemcsak az emberi agy működésének mélyebb megértéséhez járulhat hozzá, hanem kommunikációs akadályokkal élőknek is segíthet: elméletileg szöveggé formálható mindaz, amit valaki nem tud elmondani. Mindezek dacára felvetődnek etikai kérdések, hiszen a gondolatok ilyen fokú dekódolása érzékeny témákhoz vezethet. A kutatók hangsúlyozzák, hogy a modell csak a résztvevők beleegyezésével, nem invazív módon dolgozik, és magánjellegű, tudatalatti gondolatokat nem képes megfejteni.

Összegzésként megjegyezhető, hogy az MI-vel támogatott agydekódolás új korszakot nyithat a kommunikációban és a neurológiában – az viszont, hogy saját gondolataink szövegesen visszaköszönjenek, egyelőre csak tudatos, kívülről is megfigyelhető tartalmakra korlátozódik.