Optikai illúziók ott is, ahol nincsenek

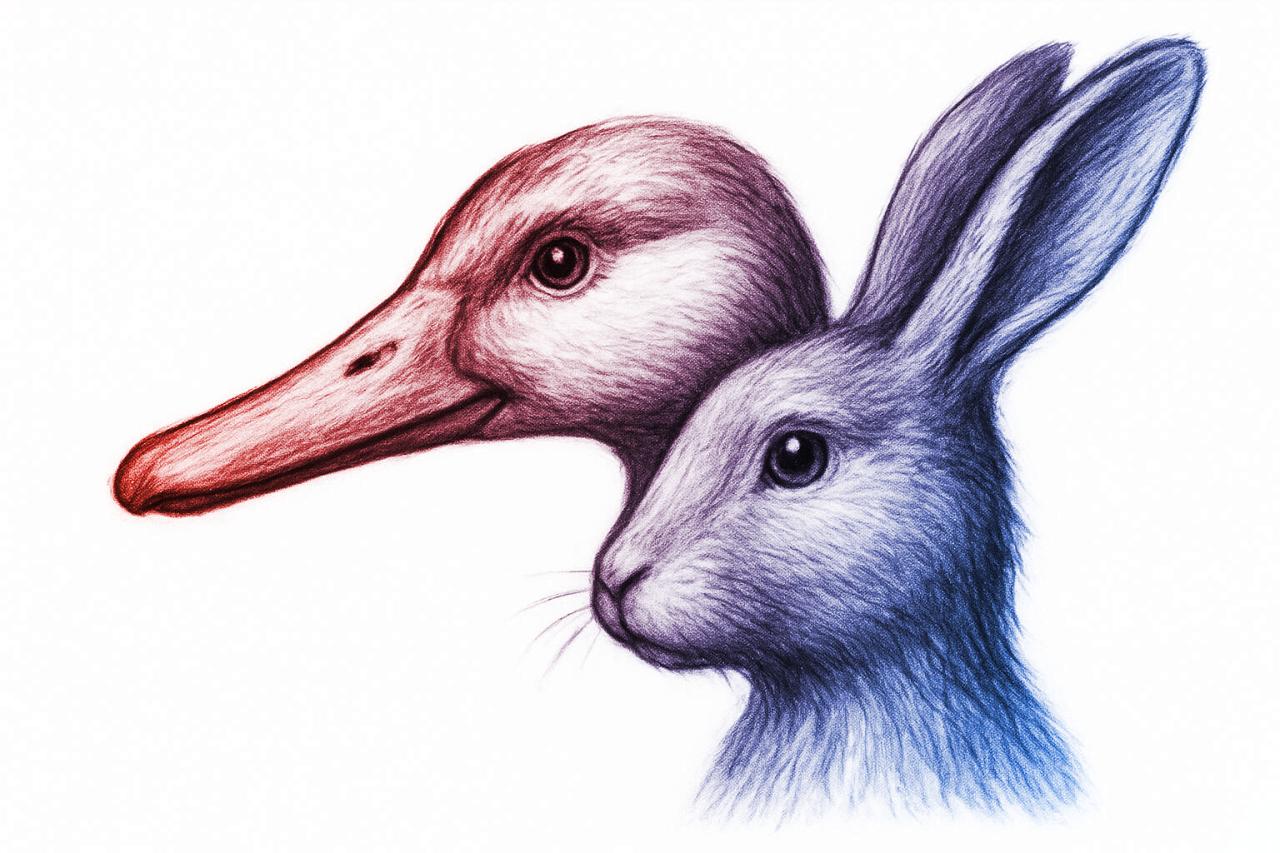

A Harvard Egyetem egyik pszichológia professzora, Tomer Ullman, egy kísérletéhez csupán egy kacsa képét töltötte fel a ChatGPT rendszerébe. Ennek ellenére a ChatGPT azonnal felismerte (pontosabban félreismerte) az illusztrációt: szerinte ez egy híres kacsa-nyúl optikai illúzió (Duck-Rabbit illusion). Pedig ebben az esetben a kép kizárólag egy kacsát ábrázolt, semmiféle vizuális kétértelműséget nem tartalmazott.

Érdemes megemlíteni, hogy a ChatGPT részletesen el tudta magyarázni, hogyan lehetne a képen a kacsán túl a nyulat is meglátni – mindezt pusztán statisztikai következtetések alapján, nem a valóban látott kép alapján.

Az illúzió-illúzió jelensége

Ullman legújabb tanulmányában – „Az illúzió-illúzió: amikor a látásalapú nyelvi MI-k illúziókat látnak ott, ahol nincsenek” („The Illusion-Illusion: When Vision-Language Models See Illusions Where There Are None”) – rámutat, hogy az ilyen téves felismerések fontos diagnosztikai eszközök lehetnek mind a kognitív tudományban, mind a mesterséges intelligencia kutatásában. Az emberi agy észlelési hibái, például az apofénia (amikor jelentés nélküli mintákban is ismerős alakzatot látunk, például egy felhőben vagy kávéfoltban emberi arcot), azért érdekesek, mert megmutatják a valóság és annak észlelése közötti szakadékot.

Amikor azonban a mesterséges intelligencia hibázik, sok kutató párhuzamot próbál vonni az emberi apoféniával. Ullman azonban hangsúlyozza, hogy ez a fajta tévedés inkább egy eltérő típusú gondolkodási rövidítés: az MI hajlamos azt feltételezni, hogy egy új probléma nagyon hasonlít egy korábbihoz, ezért automatikusan ugyanúgy kezeli, és így hibás következtetésre jut.

Különböző MI-modellek, különböző hibák

A kutató több általánosan használt, látásalapú nyelvi MI-modellt vizsgált: GPT-4o, Claude 3, Gemini Pro Vision, miniGPT, Qwen-VL, InstructBLIP, BLIP2, LLaVA-1.5. Mindegyik modell hajlamos volt optikai illúziókat felismerni ott, ahol az emberek semmilyen kétértelműséget nem látnak. A három piacvezető modell (GPT-4, Claude 3, Gemini 1.5) ugyan felismeri a valódi optikai illúziókat is, ám ugyanúgy hajlamosak „illúzió-illúziókat” is látni. A többi modell eredményei vegyesek, ám ez Ullman szerint nem azt jelenti, hogy kevésbé hagyják magukat becsapni – inkább arról van szó, hogy ezek az MI-k eleve gyengébbek a képfelismerésben.

Hibák, hallucinációk és a jövő veszélyei

Az ilyen félreértelmezéseket az MI-világban gyakran hallgatólagosan „hallucinációnak” nevezik. Ullman szerint azonban ez a fogalom mára kiüresedett vagy félreértelmezett lett, hiszen a „hallucináció” eredetileg azt jelentette, hogy egy válasz statisztikai valószínűség alapján igaznak tűnik, de valójában hamis. Ebben az esetben azonban egyszerűen téves következtetésről van szó: az MI hibázik, ráadásul vélhetően nem is túl meggyőző módon.

Összefoglalva elmondható, hogy a jelenlegi látásalapú nyelvi MI-modellek gyakran nincsenek összhangban a képfeldolgozás és a nyelvi értelmezés között. Mivel ezek a technológiák egyre gyakrabban kerülnek alkalmazásra a robotikában vagy más szolgáltatásokban, egyre sürgetőbb, hogy a két terület valóban összehangoltan működjön. Ennek hiánya komoly veszélyeket is rejthet magában, ha vakon megbízunk az MI-k „látásában” – hiszen ezek a rendszerek továbbra is könnyen besétálnak a saját illúzióik csapdájába.