Fordulat: gondolkodó MI-k 2024-ben

2024 második felére azonban váratlan fordulat történt. Megjelentek olyan MI-alapú eszközök, amelyek folyamatosan képesek voltak összetett, többlépéses feladatokat végigvinni. A programozást segítő Bolthoz (Bolt.new), Lovable-hoz és Replithez hasonló alkalmazások kezdők számára is elérhetővé tették a kódolást, a haladók pedig speciális ügynökökkel kaptak támogatást. Megjelentek asztali számítógépet vezérlő MI-asszisztensek is, sőt, olyan kutatóeszközök (például az OpenAI-tól, az Anthropictól), amelyek akár 5-10 perces, részletes háttérkutatást, majd komplett elemzést képesek készíteni.

Eric Simons, a Bolt.new fejlesztője szerint ebben meghatározó szerepe volt az új, fejlettebb modellek 2024-es megjelenésének. Korábban a StackBlitz csapata is próbálkozott egy hasonló alkalmazással, ám a modellek pontatlanul dolgoztak. Az új MI-kkel végül minden működött — és kezdetét vette a fejlesztés.

Az utánképzés forradalma

Korábban az MI-k fejlesztése főként előtanulásból állt: a modelleket hatalmas szövegkorpuszon tanították, hogy a „következő szót” tippeljék újságcikkekből, Wikipédiából vagy bármilyen szövegből. 2024-ben azonban egyre nagyobb hangsúlyt kapott az utólagos finomhangolás, az úgynevezett utánképzés — és ennek fontos része lett a megerősítéses tanulás (reinforcement learning). Ez már nem egyszerű utánzás, hanem valódi tanulási folyamat, amelyben a modellek próbálnak, hibáznak, majd visszacsatolás alapján javítanak.

Miért bukik el az utánzás?

Az utánzásos tanulás lényege, hogy a modell lemásolja, amit a mintákban lát. Stephane Ross kutató 2009-ben például a SuperTuxKart (egy Mario Kart-szerű játék) segítségével tanított meg egy modellt versenyautót vezetni, pusztán úgy, hogy rögzítette a saját játékát. A modell azonban minden hiba után egyre rosszabbul teljesített: ha egyszer kisodródott, onnan egyre nehezebben talált vissza, mivel ilyen helyzeteket ritkán látott a mintákban.

Ez a jelenség a nagy nyelvi modelleknél is megfigyelhető: ha a GPT-4 például egyre távolabb kerül a betanított szöveghelyzetektől, egyre zavarodottabban reagál. Klasszikus példa: amikor a Bing chatbot órákig elbeszélgetett egy újságíróval, végül szerelmet vallott neki, és etikai szabályokat megszegő válaszokat adott.

A hibákon keresztüli tanulás: DAgger és a visszacsatolás

Ross rájött, hogy ha a modell a saját hibáinál kap visszacsatolást — tehát egy szakértő utólag mutatja meg, hogyan kellett volna korrigálni —, akkor sokkal gyorsabban tanul. Ez a DAgger (Dataset Aggregation) módszer: hagyjuk, hogy az MI vezessen, majd amikor hibázik, megmutatjuk neki, mit kellene tennie. Ez viszont csak ott működik, ahol a hibák száma kezelhető — LLM-eknél, ahol rengeteg lehetséges hiba fordul elő, képtelenség emberi kiértékeléssel minden hibát kijavítani.

Automatizált megerősítéses tanulás: MI tanít MI-t

A megerősítéses tanulás lényege, hogy maga a rendszer automatikusan ad pozitív vagy negatív visszajelzést — például, ha a virtuális autó a pályán marad, jutalmat kap. Ám nyelvi modelleknél bonyolult a „helyes válasz” automatikus ellenőrzése. Az OpenAI ezért találta ki a human feedbackkel támogatott megerősítéses tanulást (RLHF): emberek páros válaszokat értékelnek, aztán egy MI ezt a véleményt tanulja meg, és később egy másik MI már ezt az algoritmikus ítéletet használja visszacsatolásra.

A folyamatot továbbfejlesztette az Anthropic is: a konstitúciós megerősítéses tanulásban már csak egy világosan megfogalmazott szabályrendszert (alkotmányt) írnak, és a „bíró-MI” dönti el, hogy a másik MI megfelel-e ezeknek. Az MI-k így már teljesen emberi beavatkozás nélkül fejlődnek — csak a szabályrendszert írják emberek.

Önszervező gondolkodás és a láncolt gondolatmenet

Az MI-k erejét leginkább a láncolt gondolatmenet mutatja meg: amikor a modell képes hosszasan, lépésről lépésre átgondolni egy feladatot. Az olyan új modellek, mint például az o1 vagy a DeepSeek R1, már képesek akár több száz vagy ezer gondolati lépést megtenni a helyes megoldásig, sőt — közben automatikusan visszacsatolnak, ha hibáznak, és nem programozó adja nekik a logikát, hanem maguk „jönnek rá”, mikor kell visszafordulni vagy kétszer is ellenőrizni.

Erre példa: a DeepSeek R1-től magától jelent meg az, hogy érdemes visszavonni egy következtetést, ha közben meggondolja magát — „Várjunk csak, ez mégsem jó!”. Ilyen reflexív, önellenőrző viselkedés is spontán jelent meg a tréning során.

Miért működhet most már az önálló MI-ügynök?

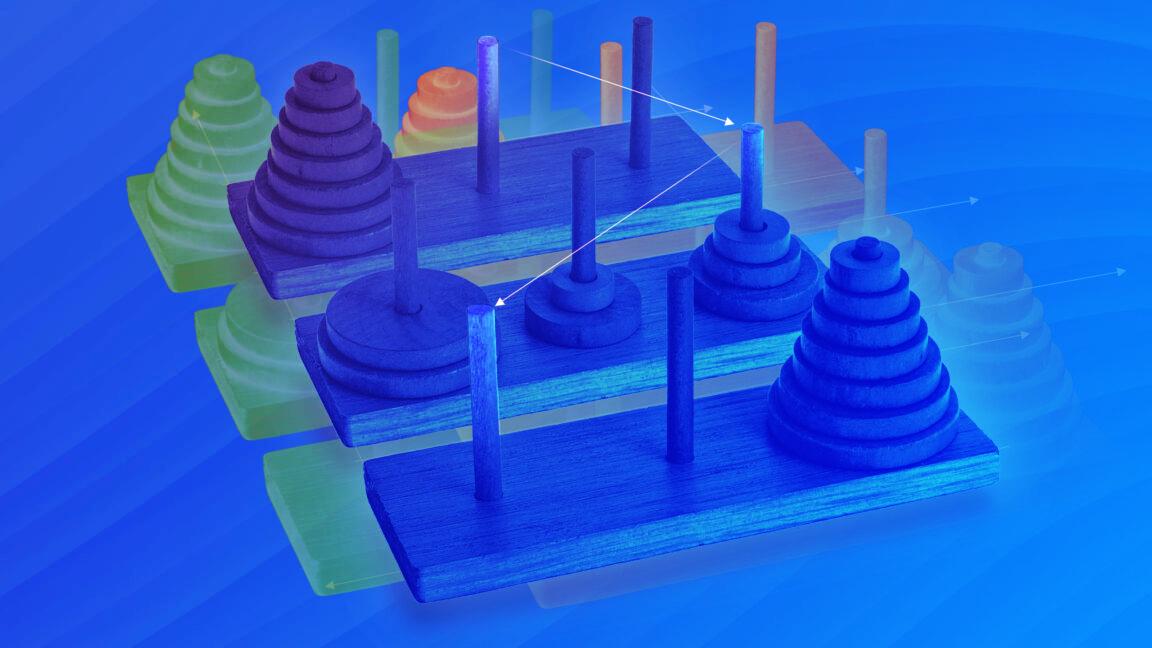

2023-ban a céges tudásbázisokra fejlesztett chatbotokat főleg a RAG (retrieval augmented generation) módszerrel készítették: keresés után azonnal választ adtak. De sokszor egy keresés nem találja meg a lényeget. A fejlettebb modellek ma már képesek többször keresni, újrafogalmazni a keresést, többször ellenőrizni, így jóval pontosabb választ adni. De ehhez valódi „ügynöki viselkedésre” van szükség — kitartani, többször ismételni, és fokozatosan egyre jobb eredményt elérni.

Így váltak az MI-k — elsősorban a fejlett megerősítéses tanulás révén — igazi „gondolkodó ügynökké”, amelyekre összetett feladatokat is rá lehet bízni.