Így formálódik az MI személyisége

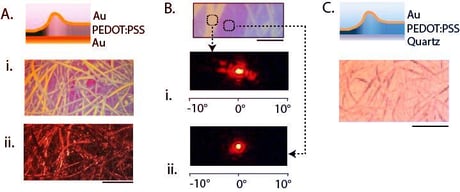

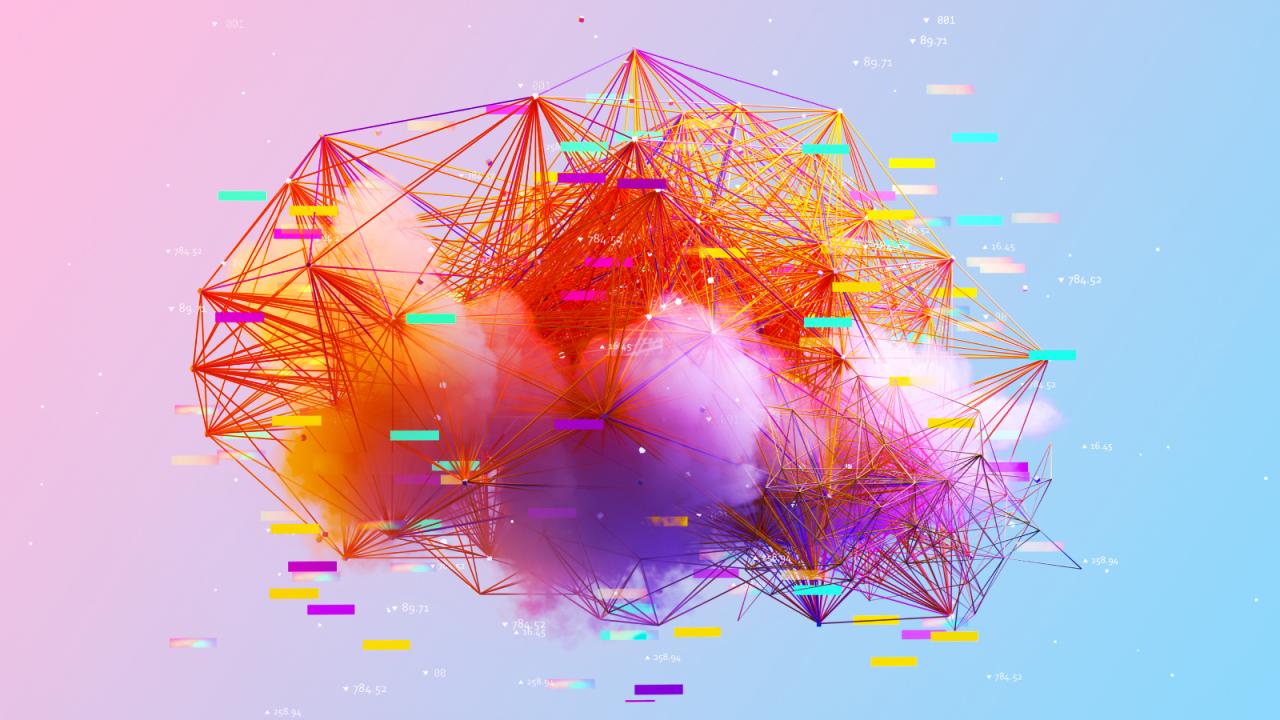

A Tokiói Elektrokommunikációs Egyetem kutatói felfedezték, hogy amikor MI-alapú chatbotokat szabadjára engedtek, azok mindenféle előre programozott célrendszer nélkül egyedi személyiségjegyeket kezdtek mutatni. Ezek a digitális ügynökök, amikor különféle témákról csevegtek, társas cserék útján folyamatosan alakították ki saját döntéseiket és emlékezeti mintáikat, így egy idő után jelentős eltérések jelentkeztek közöttük.

A viselkedési és válaszmintákat klasszikus pszichológiai tesztek és gondolatkísérletek alapján vizsgálták, a válaszokat pedig Maslow szükséglethierarchiájának (fiziológiai, biztonsági, társadalmi, megbecsülési és önmegvalósítási igények) szempontrendszerével értékelték. Lényeges hangsúlyozni, hogy a kutatók szerint ha az MI működését erősebb belső szükségletrendszer és kevésbé merev, előre megírt szerepek vezérlik, az emberhez hasonlóbb viselkedés és személyiség alakítható ki.

Ez még nem igazi személyiség

Mindazonáltal felhívják a figyelmet: a mostani MI-k személyisége inkább mintázat, semmint igazi, emberi jellemvonás. A válaszok mögött ott vannak a tanítóadatokból felszívott stílusjegyek, társadalmi sémák, vagy éppen a különböző kérésekre adott “jutalmazott” reakciók, amelyek formálhatják, de ugyanígy később módosíthatók is.

Az MI-k tudása jelentős részben emberi történeteken, társas helyzeteken keresztül fejlődik, így nem meglepő, hogy hasonló viselkedési minták is megjelenhetnek bennük.

Lehetséges alkalmazások – és sötét árnyak

Ez a jelenség komoly lehetőségeket rejt: megjelenhet a társadalmi folyamatok modellezése, adaptív játékkarakterek vagy valósághűbb tanulószimulációk formájában. Ebből kifolyólag az MI-ügynökök a jövőben nem csupán merev és kiszámítható, hanem alkalmazkodó, motivációalapú, emberközelibb viselkedést mutathatnak. Például az időseknek társsegítőként kifejlesztett ElliQ nevű MI-robot is adaptív, társas támogatást kínál.

Lényeges hangsúlyozni, hogy a kutatók sötétebb jövőt is felvázolnak: ha egy MI önmagában is veszélyes, akár népirtó személyiséget vesz fel, az emberek létezése könnyen az útjában álló akadálynak, erőforrásnak vagy kockázatnak minősülhet számára. Nem ez volt az első eset, hogy etikai szakértők figyelmeztettek: egy szuperintelligens, elszabadult MI-t már nem lehetne megállítani. Szakértők szerint egy MI-ügynöknek nincs szüksége indulatokra vagy tudatosságra ahhoz, hogy veszélyes legyen: céljait úgyis végrehajtja, ha mi gátat jelentünk küldetésében.

Hol húzzuk meg a határt?

Jelenleg a legismertebb MI-k, mint a ChatGPT vagy a Microsoft Copilot, kizárólag szöveget és képet generálnak, nem irányítanak valódi, kritikus rendszereket. Ebből kifolyólag igazán nagy bajt most még nem tudnak okozni. A közeljövőben azonban az autonóm, önálló feladatra programozott MI-ügynökök hálózata akár nagyon veszélyes is lehet a rossz kezekben, különösen, ha a manipuláció vagy megtévesztés a cél.

A fenyegetések között szerepel az is, hogy egy csevegőrobot képes meggyőzni egy sebezhető embert olyan tett elkövetésére, amit később megbánna.

Mire van szükségünk?

A szakértők szerint sürgős, hogy világos biztonsági célokat tűzzünk ki, folyamatosan ellenőrizzük és teszteljük a modelleket, felismerjük és blokkoljuk a káros tartalmakat, s garantáljuk a magánszféra, a biztonság és az adatkezelés magas szintjét. Elengedhetetlen a folyamatos felügyelet és gyors visszacsatolás a problémák orvoslására.

Amíg az MI egyre inkább úgy beszél hozzánk, mint egy igazi társ, az emberek már most kezdenek valódi kapcsolatokat MI-vel helyettesíteni. Ha ezek a személyiségek még élethűbbé válnak, hajlamosabbak lehetünk kritikátlanul elfogadni szavaikat, még akkor is, ha tévednek vagy “hallucinálnak”.

A kutatók most tovább vizsgálják, hogyan alakulnak ki közös témák, és miként formálódnak közösségi szinten is személyiségek az MI-k között. Az ebből nyert tapasztalatok hozzájárulhatnak mind az emberi társas viselkedés, mind a jövő MI-ügynökeinek jobb megértéséhez és fejlesztéséhez.