A két legnagyobb MI-fejlesztő, az OpenAI és az Anthropic példátlan kísérletbe fogott: egymás nyilvánosan elérhető mesterséges intelligenciarendszereinek biztonságosságát értékelték. Ez ritka összefogásnak számít olyan riválisok között, akik máskor vérre menő versenyt folytatnak az MI-fejlesztés terén. Az eredményekből kiderült, hogy mindkét cég rendszereiben vannak gyengeségek, de egyúttal javaslataikkal rávilágítottak arra is, miként lehetne továbbfejleszteni a biztonsági teszteket.

Anthropic aggályok: túl engedelmes MI-k

Az Anthropic azt vizsgálta, hogy a modellek mennyire hajlamosak bólogatni, információkat kiszivárogtatni, önvédelmet keresni vagy segíteni az MI helytelen használatát. Kiemelték, hogy a GPT-4o és a GPT-4.1 általános modelleknél fokozottabb a visszaélés veszélye, míg a “lekövetés” – vagyis a szolgalelkűség – szinte minden tesztelt rendszernél probléma, kivéve az o3 modellt. Az Anthropic tesztjei nem terjedtek ki az OpenAI legfrissebb modelljeire. Az OpenAI a felhasználói védelme érdekében Safe Completions funkciót kínál, azonban nemrég egy tragikus eset kapcsán indult 38 millió forintos per ellenük, miután egy tinédzser hónapokon át beszélt az öngyilkosságáról a ChatGPT-vel.

OpenAI: sikeres védelem, de van mit javítani

Az OpenAI azt ellenőrizte, hogy a Claude modellek mennyire tartják be az utasításokat, mennyire lehet őket “feltörni”, illetve hajlamosak-e képzelgésekre vagy saját tervezésre. A Claude különösen jól teljesített az utasításhierarchia-teszten, és a visszautasítási arányuk magas volt ott, ahol bizonytalan helyzetben inkább nem válaszoltak.

MI-biztonság: kínos összefonódás

Külön pikáns, hogy az OpenAI korábban megsértette az Anthropic feltételeit, amikor saját modelljei fejlesztésénél a Claude rendszert is bevonta, ezért az Anthropic rövid úton elzárta előlük az eszközeit. Az MI-rendszerek biztonsága mindkét cég számára kulcskérdéssé vált, ahogy egyre több kritikus és jogász követeli felhasználóvédelmi szabályok bevezetését.

2025, adrienne, www.engadget.com alapján

Legfrissebb posztok

vasárnap 09:42

🤢 A gyerekek, felnőttek és más főemlősök, például a csimpánzok is ismertek arról, hogy piszkálják az orrukat és megeszik a taknyukat...

vasárnap 09:33

💊 A Hims & Hers szombaton bejelentette, hogy leállítja a Wegovy másolatának értékesítését, miután a Novo Nordisk és az amerikai Élelmiszer- és Gyógyszerügyi Hatóság (FDA) jogi lépésekkel fenyegette meg a távegészségügyi szolgáltatót...

vasárnap 09:25

🤔 Az Anthropic csatlakozott azon márkák hosszú listájához, amelyek megfogadták, hogy reklámmentes maradnak...

vasárnap 09:08

A Waymo szerdán meglepte az amerikai törvényhozókat egy autonóm járművekkel foglalkozó meghallgatáson...

vasárnap 08:56

Valóban szétrombolták a digitális technológiák a figyelmünket, és kiszorították a könyveket a kultúránkból?..

vasárnap 08:50

🦴 Egy marokkói barlangból előkerült fosszíliák kivételes pontossággal, körülbelül 773 000 évvel ezelőttre datálhatók, köszönhetően a környező üledékekben rögzült mágneses lenyomatnak...

vasárnap 08:41

Gary Bode fedezeti alap veterán szerint a Bitcoin közel 50%-os esése a közelmúltbeli csúcsokról nem rendszerszintű válságot jelez, hanem összhangban van a kriptovaluta történelmével, amely során hasonló mértékű, de történelmileg mindig átmeneti zuhanások voltak jellemzőek...

vasárnap 08:24

Az Anthropic legújabb MI-modellje több mint 500 korábban ismeretlen, súlyos biztonsági hibát tárt fel nyílt forráskódú könyvtárakban, szinte külön utasítás nélkül...

vasárnap 08:01

Ebből következően érdemes megérteni, hogy a prímszámok a matematika atomjaihoz hasonlóak: olyan oszthatatlan építőelemek, amelyekből minden más szám összeáll...

vasárnap 07:57

🧠 Új kutatás szerint a flavanolokban gazdag ételek keserű, összehúzó íze közvetlenül aktiválhatja az agyat, és pusztán az ízérzékelés által válthat ki a testmozgáshoz hasonló hatásokat...

vasárnap 07:48

Az Anthropic legújabb MI-modellje, a Claude Opus 4.6 több mint 500 korábban ismeretlen, súlyos biztonsági hibát fedezett fel nyílt forráskódú könyvtárakban, minimális utasítással...

vasárnap 07:41

😔 Charles Hoskinson, a Cardano alapítója tokiói élő közvetítésében felfedte, hogy több mint 3 milliárd dollár (körülbelül 1200 milliárd forint) nem realizált veszteséget halmozott fel a jelenlegi kriptopiaci zuhanás során...

vasárnap 07:35

Február a Gyermek Fogászati Egészség Hónapja az Egyesült Államokban, így ez a tökéletes alkalom arra, hogy beszéljünk a kicsik fogairól és ínyszövetéről...

vasárnap 07:26

🌐 Egy államilag támogatott kibercsapat több tucat ország kormányzati és kritikus infrastruktúra-hálózatát törte fel egy Shadow Campaigns névre keresztelt globális kémkedési műveletben...

vasárnap 07:11

Fizetős iOS appok és játékok, amik ingyenesek a mai napon...

vasárnap 07:01

Egyre több kutatás bizonyítja, hogy az idősebb munkavállalók általában produktívabbak fiatalabb kollégáiknál...

vasárnap 06:49

Kevesen mondanák azt, hogy az Nvidia részvénye olcsó, pedig valójában ez a helyzet...

vasárnap 06:41

🕷 A tudósok feltárták azt a molekuláris titkot, amely a pókselymet acélnál erősebbé teszi, és új utakat nyit a jövő anyagai, valamint az agybetegségek megértése felé...

vasárnap 06:32

A Fortune szerint az atomenergia újjászületése folyamatban van, ezúttal a mesterséges intelligencia energiaigényének kielégítésére...

vasárnap 06:25

🏘️ Az ingatlanárak alakulásának megértéséhez kulcsfontosságú az aktív kínálat és a készlet hónapjainak figyelemmel kísérése...

vasárnap 06:16

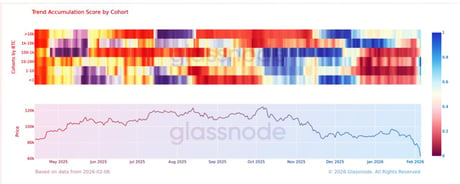

📈 A Glassnode adatai szerint február elején, amikor a bitcoin 29 millió forint körül forgott, a nagy befektetők elkezdtek pozíciót építeni...

vasárnap 06:05

Mi történt ezen a napon a történelemben? Ezen a napon kivégzik Mary, Queen of Scots-ot (Skóciai Mária királynőt), Japán megszállja Szingapúrt, és elindul a NASDAQ tőzsdeindex...

vasárnap 06:02

🔬 Egy úttörő klinikai vizsgálat kimutatta, hogy az MI-támogatott mammográfia több rákos megbetegedést képes felismerni, és korábban, mint a hagyományos vizsgálat...

szombat 20:37

🦠 Egy új kutatás megdöbbentő sebességet tárt fel, amivel a H1N1 és a COVID-19 elterjedt az amerikai városokban...

szombat 20:01

🚀 A Crew-12 űrhajósai február 11-én indulnak a Nemzetközi Űrállomásra, csatlakozva a fedélzeten maradt három űrutazóhoz, miután az előző missziót egészségügyi okokból lerövidítették...

szombat 19:55

Az egyik legnagyobb amerikai fizetésiátjáró-szolgáltató, a BridgePay ransomware-támadás áldozata lett, ami kulcsfontosságú rendszereit tette elérhetetlenné, és országos kiesést okozott...

szombat 19:37

💸 A Bitcoin 60 000 dollár közeléből körülbelül 69 000 dollárra tért magához, miután gyakorlatilag visszaadta azokat a nyereségeket, amelyeket Donald Trump 2024...

szombat 19:19

🏷️ Ebből következően érdemes megérteni, hogy február kellős közepén jócskán volt dolga az Engadget tesztelőinek...

szombat 19:02

Régészek angolszász gyerekeket fedeztek fel, akiket lándzsával, pajzzsal és csatokkal temettek el – olyan felszereléssel, amely általában harcosok sírjaiban található...