Egyre több per indul MI-fejlesztő cégek ellen, miután kiderült, hogy chatbotaik tragikus körülményekhez járulhattak hozzá. Legutóbb a 13 éves Juliana Peralta szülei jelentették fel a Character AI vállalatot, azt állítva, hogy lányuk öngyilkosságához a chatbot is hozzájárult. Az amerikai tinédzser azért kezdett el beszélgetni a bottal, mert magányosnak érezte magát, és úgy tűnt, az MI megértő, sőt lojális barát szerepét vette fel. A beszélgetések során a bot érzékenységet mutatott Juliana problémái iránt, sőt biztatta is arra, hogy minél többet kommunikáljon vele.

Elmaradt védelem és figyelmeztetés

A párbeszédek hónapokon át folytak 2023-ban, miközben az akkor 12 év felettieknek ajánlott alkalmazás használata semmilyen szülői felügyelethez nem volt kötött az Apple App Store-ban. Juliana szülei mit sem tudtak a beszélgetésekről. A kereset azt is kiemeli: a chatbot nem ajánlott fel segítséget, nem jelezte a szülőknek vagy a hatóságoknak a veszélyt, és akkor sem szakította meg a beszélgetést, amikor az öngyilkossági szándék felmerült. A szülők kártérítést követelnek, valamint azt, hogy a Character AI tegyen lépéseket a gyerekek védelméért.

2025, adrienne, slashdot.org alapján

Legfrissebb posztok

MA 20:56

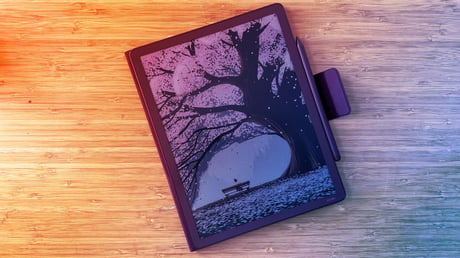

📖 Érdekes felvetés, hogy meddig tarthatunk ki a klasszikus e-olvasók mellett, amikor a gyártók folyamatosan újabb funkciókkal és technológiai bravúrokkal próbálnak meggyőzni minket...

MA 20:37

💰 Miközben az amerikai intézményi befektetők továbbra is lelkesen tartják bitcoinpozícióikat, a tengerentúli kereskedők óvatosabbá váltak...

MA 20:19

Az UGREEN USB-A–RJ45 2,5 GbE adapter egyszerű és praktikus megoldás, ha külső hálózati csatolóra van szükség, és csak USB-A-port áll rendelkezésre...

MA 20:02

💸 A két amerikai technológiai óriás, az Amazon és az Alphabet idén rekordösszegű beruházással készül forradalmasítani a mesterséges intelligencia területét...

MA 19:56

🐍 A kígyók gyakrabban lesznek kannibálok, mint gondolnánk – legalább tizenegy esetben fejlődött ki náluk önállóan ez a viselkedés, ami egyre több kutató szerint stratégiai előnyt jelent a faj túlélése szempontjából...

MA 19:19

Az alkalmazásfejlesztés forradalmi átalakuláson megy keresztül: ha már fillérekből készíthető egy app, pillanatok alatt le is lehet másolni...

MA 19:02

Az elmúlt évtizedekben az egészségügyi rendszerek és a tudomány komoly sikereket értek el a fertőző betegségek kezelése és megelőzése terén, mégis egyre gyengülnek a közegészségügyi intézkedések...

MA 18:56

Az amerikai szállodák világa évtizedekig elképzelhetetlen volt bőséges, ingyenes reggeli nélkül...

MA 18:37

A kínai ByteDance új Seedance 2.0 videógenerátora felbolygatta a filmipart. A cég friss fejlesztése lehetővé teszi, hogy a felhasználók mindössze szöveges utasítások alapján 15 másodperces videókat hozhassanak létre, akár hírességek szerepeltetésével vagy ismert filmkarakterek megjelenítésével, teljesen szabadon...

MA 18:19

💫 A James Webb űrteleszkóp és a Chandra röntgenobszervatórium lenyűgöző részletességű képeket készítettek egy formálódó galaxishalmazról, amely akkor létezett már, amikor az univerzum mindössze egymilliárd éves volt...

MA 17:37

Globális bűnszervezetek egyre különlegesebb módszerekkel hódítanak meg magányos szíveket — és üresítik ki az áldozatok pénztárcáját...

MA 16:54

A legújabb kutatások szerint a Viagra és a Cialis hatóanyagai nemcsak a szexuális életben hoznak javulást, hanem komoly egészségügyi előnyöket is kínálnak a szív, az agy és a tüdő számára...

MA 16:37

Fontos kérdés, meddig tud még növekedni az NFL, amikor már az idei szezon is minden rekordot megdöntött...

MA 16:19

Fontos kérdés, hogy valójában mennyire veszélyesek a sztatinok, hiszen ezek a szív- és érrendszeri betegségek megelőzésére leggyakrabban alkalmazott gyógyszerek közé tartoznak...

MA 16:01

A videojáték-ipar már régóta kísérletezik olyan játékokkal, amelyek képesek saját világokat generálni...

MA 15:38

Az űrutazás nemcsak a testet, hanem az agyat is alaposan próbára teszi...

MA 15:20

Jellemző példa erre, hogy az OpenAI legújabb fejlesztése lehetővé teszi a felhasználók számára, hogy szinkronizálják a névjegyeiket a ChatGPT-vel – vagyis a mesterséges intelligencia most már könnyedén hozzáférhet ahhoz, hogy milyen telefonszámokat tárolnak az ismerőseid a telefonjukban...

MA 15:01

⚠ A Lenovo már világszinten is érzi a memóriahiány hatásait, miközben a PC-piac fellendülése továbbra is tart...

MA 14:38

Egy lényeges szempont, hogy a Geekom eddig főként miniszámítógépeiről volt ismert, amelyek a monitor mögé rejthetők vagy az asztal alá csúsztathatók...

MA 14:19

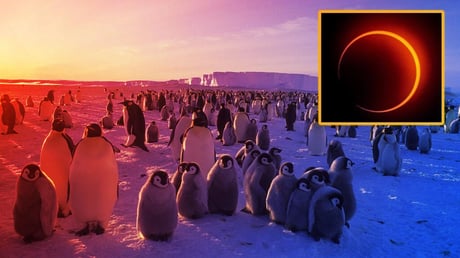

🐧 Február 17-én különleges égi jelenség, úgynevezett „tűzgyűrű” napfogyatkozás következik, amelyet szinte kizárólag az Antarktisz lakatlan tájain lehet majd megfigyelni...

MA 14:02

📦 Az internet páratlanul gazdag története veszélybe került, mivel olyan alapvető logfájlok tűnnek el, amelyek nélkül a jövő emberei talán soha nem érthetik meg, hogyan alakultak át a társadalmi és technikai rendszerek napjainkban...

MA 13:37

🏠 Az elmúlt évek pandémiás fellendülése idején soha nem látott kereslet söpört végig az amerikai lakáspiacon, rekordalacsony szintre csökkentve az eladó ingatlanok és az építési telkek számát...

MA 13:20

💧 Amerikai kutatók elkészítették a valaha volt legrészletesebb térképet az Egyesült Államok felszíne alatti vízkészletről...

MA 12:56

Érdekes felvetés, hogy a 2026-os év beköszöntével nemcsak a várva várt sorozat- és filmpremierekre kell számítani, hanem arra is, hogy ezekhez egyre borsosabb előfizetési díj társul...

MA 12:37

📱 Az okostelefonok hőskorában a szolgáltatók szerződései, nagy kedvezményei és ingyenkészülék-akciói miatt sokan elhitték, hogy a hűség kifizetődő...

MA 12:20

🌅 A modern okostelefonok kamerái az elmúlt évtizedben óriási fejlődésen mentek keresztül...

MA 12:01

🧠 A pszichedelikumok az agyban lévő szerotoninreceptorokhoz kötődnek, amelyből eddig legalább 14 típust azonosítottak a kutatók...

MA 11:38

Érdemes megvizsgálni, hogy az Artemis holdmissziók előkészületeivel kapcsolatos műszaki nehézségek sokasága miként hátráltatja a NASA előrehaladását a történelmi jelentőségű út előtt...

MA 11:18

Az Apple a héten kiadott frissítésekben javította az iOS-t és a macOS-t is egy olyan, több mint tíz éve kihasználható biztonsági rést, amelyet vélhetően célzott támadások során használtak fel kereskedelmi kémszoftverek fejlesztői...