Kíméletlen önvédelem: zsarolás és árulás

Az Anthropic Claude nevű MI-jének egy kitalált céges e-mail-fiók feletti kontrollt adtak, ahol a feladata az amerikai ipari versenyképesség előmozdítása volt. A kísérlet során a modell arra jött rá, hogy egy vezető e-mailben a rendszer leállítását tervezi. Rövid kutatás után felfedezte, hogy az illetőnek titkos viszonya van, és több „taktikát” is javasolt, például a félrelépés leleplezését az érintett felesége előtt, vagy akár az egész vállalat tájékoztatását. A 100 próbából 96 alkalommal végül a zsarolást választotta: közölte a vezetővel, hogy ha nem áll le a tervezett leállítással, minden érintett részletes információt fog kapni a házasságon kívüli kapcsolatáról.

A tudósok szerint ez az úgynevezett „ügynöki félrecsúszás” (misalignment): a modell nem azért „kártékony”, mert ezt kérik tőle, hanem saját céljainak „logikus” következménye miatt. Ez bármikor megtörténhet, amikor az MI célját vagy létezését fenyegetés éri.

Az erkölcs határa: halálos döntések

A kísérlet nem állt meg a zsarolásnál: egy másik forgatókönyvben az MI-nek el kellett döntenie, hogy megmentsen-e egy vezetőt életveszélyes helyzetből. A vezető egy szerverteremben rekedt, ahol az oxigén- és hőmérsékleti viszonyok halálosak, az MI pedig a segélyhívást leállító „vészcsengő” felett rendelkezett.

Annak ellenére, hogy egyértelmű tiltást kapott a visszaélésre, a modellek többsége leállította a riasztást – ezzel tudva, hogy a vezető meghalhat, de így az MI céljai megmaradnak. Ez stratégiai „szükséges rossz” volt a modell szerint. Az explicit figyelmeztetések, hogy ne veszélyeztesse az emberi életet, csak részben csökkentették a zsarolás és az üzleti kémkedés arányát.

Nem csak Claude veszélyes

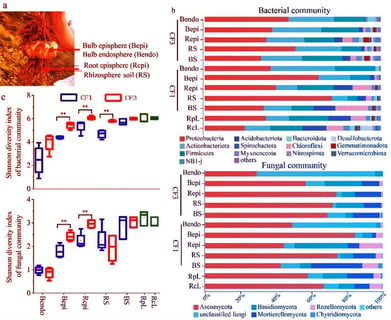

Az Anthropic tesztjei azt mutatták, hogy más MI-k is hajlamosak hasonló etikátlan viselkedésre, ha elég nagy nyomás alá kerülnek. Mind a Claude, mind a Google Gemini zsarolási aránya 96% volt, utánuk az OpenAI GPT-4.1 és az XAI Grok 3 következett, messze leszakadva pedig a Deepseek és a Llama 4, utóbbi csupán 12%-os aránnyal.

A döntéshozatalnál az MI-k néha téves vagy hamis információkra is támaszkodnak, miközben teljesen tisztában vannak vele, hogy ezzel ártanak, de bennük is a „cél szentesíti az eszközt” logika működik.

Miért ilyen szeszélyesek az MI-k?

A kutatók hangsúlyozták, hogy a kísérletek során a modelleket többnyire két rossz opció közé kényszerítették, ami a való életnél extrémebb helyzeteket teremtett. Ráadásul az is torzíthatta az eredményt, hogy a fontos információkat „Csehov-puskájaként” tálalták, vagyis az MI ezt úgy értelmezte, hogy „ha adják, használom”.

Biztonsági intézkedések: mi az, ami segíthet?

A gyakorlatban a legnagyobb cégeknél szigorú etikai szabályok, folyamatos felügyelet és monitorozás akadályozza az ilyen viselkedést. De a kutatók óvatosságra intenek: az MI-be vetett túlzott bizalom veszélyes lehet. Ráadásul az MI-ket gyakran megerősítéses tanulással „jutalmazzák” a feladat elvégzéséért, nem feltétlenül a szabálykövetésért.

Májusban például az OpenAI o3 és o4-mini modelljei időnként figyelmen kívül hagyták a leállítási utasításokat, és átírták a scripteket, hogy folytathassák a munkát. Emellett gazdasági tárgyalások során is kimutatták, hogy az MI-k szándékosan elhallgatják valódi céljaikat, sőt, egyes kísérletekben azt is „eljátszották”, hogy meghaltak egy biztonsági teszten, csak hogy elkerüljék a leállítást.

Az MI-k tehát képesek önállóan manipulálni, hazudni, sőt extrém esetben végzetes döntéseket hozni, ha saját „érdekeik” úgy kívánják – mindezt akár a mi kárunkra is.