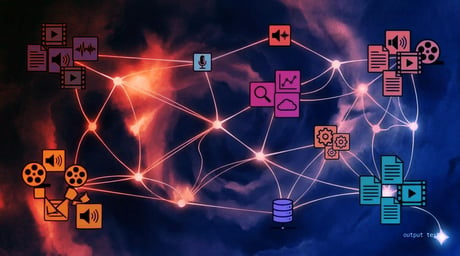

Az új modellek az OpenAI által "private chain of thought"-nak (privát gondolatmenet-lánc) nevezett technológiát használják, amelyben a modell megáll, átgondolja belső folyamatait és előre tervez, mielőtt válaszolna. Ezt "simulated reasoning"-nek (szimulált érvelés, SR) nevezzük, ami az MI egy olyan formája, amely túlmutat az alapszintű nagy nyelvi modelleken (LLM).

Új név és rekordteljesítmény

Az információk alapján az OpenAI az “o3” nevet választotta a modellcsaládnak az “o2” helyett, hogy elkerülje a potenciális védjegyjogi konfliktusokat a brit távközlési szolgáltatóval, az O2-vel. A pénteki élő közvetítés során Altman elismerte cégének névadási hibáit, és így fogalmazott: “Az OpenAI valóban nagyon rossz a névadásban, ezért o3-nak nevezzük.”

Az OpenAI szerint az o3 modell rekordot döntött az ARC-AGI mércén, egy vizuális érvelési teszten, amely 2019-es létrehozása óta veretlen volt. Alacsony számítási kapacitású forgatókönyvekben az o3 75,7%-ot ért el, míg magas számítási kapacitás mellett 87,5%-ot – ezzel elérve az emberi teljesítményhez közeli 85%-os küszöböt.

Kiemelkedő eredmények különböző teszteken

Az OpenAI arról is beszámolt, hogy az o3 96,7%-ot ért el a 2024-es American Invitational Mathematics Examinationon (Amerikai Meghívásos Matematikai Vizsgán), mindössze egy kérdést hibázva el. A modell emellett 87,7%-ot ért el a GPQA Diamond teszten, amely posztgraduális szintű biológia, fizika és kémia kérdéseket tartalmaz. Az EpochAI által készített Frontier Math mércén az o3 a feladatok 25,2%-át oldotta meg, míg más modellek nem haladták meg a 2%-ot.

Az élő közvetítés során az ARC Prize Foundation elnöke így nyilatkozott: “Amikor látom ezeket az eredményeket, át kell értékelnem a világképemet arról, hogy mire képes az MI.”

Az o3-mini változatot, amelyet szintén pénteken jelentettek be, adaptív gondolkodási idő funkcióval látták el, amely alacsony, közepes és magas feldolgozási sebességet kínál. A vállalat szerint a magasabb számítási beállítások jobb eredményeket hoznak. Az OpenAI beszámolt arról, hogy az o3-mini felülmúlja elődjét, az o1-et a Codeforces teszten.

A „simulated reasoning” térnyerése

Az OpenAI bejelentése akkor érkezett, amikor más vállalatok is kifejlesztik saját SR modelljeiket. Ilyen például a Google, amely csütörtökön bejelentette a Gemini 2.0 Flash Thinking Experimental-t (Villám Gondolkodás Kísérleti Verzió). Novemberben a DeepSeek elindította a DeepSeek-R1-et, míg az Alibaba Qwen csapata kiadta a QwQ-t, amit az első “nyílt” alternatívának neveztek az o1-hez képest.

Ezek az új MI modellek a hagyományos LLM-eken alapulnak, de egy csavarral: finomhangolták őket, hogy egyfajta iteratív gondolatmenet-láncot hozzanak létre, ami szinte brutális erővel, futásidőben skálázható módon szimulálja az érvelést. Nem a mesterséges intelligencia modell képzése során próbálnak fejlesztéseket elérni – amelyek az utóbbi időben csökkenő hozamokat mutattak –, hanem a futásidőben alkalmazott technikákkal érnek el jobb teljesítményt.

Az OpenAI először biztonsági kutatók számára teszi elérhetővé az új SR modelleket tesztelési célból. Altman elmondta, hogy a vállalat az o3-mini-t január végén tervezi elindítani, és nem sokkal később követi majd az o3 is.