Az OpenAI újabb lépést tett az online biztonság felé: két, „open-weight” elnevezésű MI-modellt tett elérhetővé, amelyekkel a fejlesztők az oldalaikon előforduló káros tartalmakat egyedi igényeik szerint szűrhetik. Ezek a modellek – gpt-oss-safeguard-120b és gpt-oss-safeguard-20b – a méretük alapján kapták a nevüket, és az OpenAI korábban bemutatott modelljeinek továbbfejlesztett változatai. Az „open-weight” azt jelenti, hogy a modellek tanulási paraméterei bárki számára hozzáférhetők – ellentétben a teljesen nyílt forráskódú modellekkel, amelyeket bárki át is írhat, módosíthat.

Több átláthatóság, több irányítás

A fejlesztők testre szabhatják ezeknek a modelleknek a működését saját szabályzataik alapján – például egy termékértékelő oldal ezzel szűrheti ki a hamis értékeléseket, egy videojátékos fórum pedig a csalásról szóló beszélgetéseket. Mivel ezek az MI-modellek a „gondolatmenetüket” is láthatóvá teszik, a fejlesztők pontosabb képet kapnak arról is, hogyan születik egy adott döntés.

Bővülő biztonsági közösség

Az új modellek fejlesztésében a Robust Open Online Safety Tools (ROOST) segített, a Discord és a SafetyKit pedig tesztelte őket. Egyelőre csak kutatási verzióban érhetők el, az OpenAI pedig visszajelzéseket is vár a szakmától. A ROOST közben új közösséget is létrehoz, ahol a biztonsággal foglalkozó szakemberek cserélhetnek tapasztalatot.

Túl a haszonszerzésen?

Az új fejlesztésekkel az OpenAI a kritikusokat is szeretné megnyugtatni: sokan vádolták a céget azzal, hogy túl gyorsan terjeszkedik, miközben háttérbe szorul az MI etikai oldala. Az OpenAI értéke ma már több billió forint – nem csoda, hogy a világ legértékesebb techstartupjai között tartják számon. Az MI egyre nagyobb erejével elengedhetetlenné váltak az ilyen biztonsági fejlesztések. A modellek súlyai a Hugging Face oldaláról letölthetők.

2025, adrienne, www.cnbc.com alapján

Legfrissebb posztok

MA 09:42

🤢 A gyerekek, felnőttek és más főemlősök, például a csimpánzok is ismertek arról, hogy piszkálják az orrukat és megeszik a taknyukat...

MA 09:33

💊 A Hims & Hers szombaton bejelentette, hogy leállítja a Wegovy másolatának értékesítését, miután a Novo Nordisk és az amerikai Élelmiszer- és Gyógyszerügyi Hatóság (FDA) jogi lépésekkel fenyegette meg a távegészségügyi szolgáltatót...

MA 09:25

🤔 Az Anthropic csatlakozott azon márkák hosszú listájához, amelyek megfogadták, hogy reklámmentes maradnak...

MA 09:08

A Waymo szerdán meglepte az amerikai törvényhozókat egy autonóm járművekkel foglalkozó meghallgatáson...

MA 08:56

Valóban szétrombolták a digitális technológiák a figyelmünket, és kiszorították a könyveket a kultúránkból?..

MA 08:50

🦴 Egy marokkói barlangból előkerült fosszíliák kivételes pontossággal, körülbelül 773 000 évvel ezelőttre datálhatók, köszönhetően a környező üledékekben rögzült mágneses lenyomatnak...

MA 08:41

Gary Bode fedezeti alap veterán szerint a Bitcoin közel 50%-os esése a közelmúltbeli csúcsokról nem rendszerszintű válságot jelez, hanem összhangban van a kriptovaluta történelmével, amely során hasonló mértékű, de történelmileg mindig átmeneti zuhanások voltak jellemzőek...

MA 08:24

Az Anthropic legújabb MI-modellje több mint 500 korábban ismeretlen, súlyos biztonsági hibát tárt fel nyílt forráskódú könyvtárakban, szinte külön utasítás nélkül...

MA 08:01

Ebből következően érdemes megérteni, hogy a prímszámok a matematika atomjaihoz hasonlóak: olyan oszthatatlan építőelemek, amelyekből minden más szám összeáll...

MA 07:57

🧠 Új kutatás szerint a flavanolokban gazdag ételek keserű, összehúzó íze közvetlenül aktiválhatja az agyat, és pusztán az ízérzékelés által válthat ki a testmozgáshoz hasonló hatásokat...

MA 07:48

Az Anthropic legújabb MI-modellje, a Claude Opus 4.6 több mint 500 korábban ismeretlen, súlyos biztonsági hibát fedezett fel nyílt forráskódú könyvtárakban, minimális utasítással...

MA 07:41

😔 Charles Hoskinson, a Cardano alapítója tokiói élő közvetítésében felfedte, hogy több mint 3 milliárd dollár (körülbelül 1200 milliárd forint) nem realizált veszteséget halmozott fel a jelenlegi kriptopiaci zuhanás során...

MA 07:35

Február a Gyermek Fogászati Egészség Hónapja az Egyesült Államokban, így ez a tökéletes alkalom arra, hogy beszéljünk a kicsik fogairól és ínyszövetéről...

MA 07:26

🌐 Egy államilag támogatott kibercsapat több tucat ország kormányzati és kritikus infrastruktúra-hálózatát törte fel egy Shadow Campaigns névre keresztelt globális kémkedési műveletben...

MA 07:11

Fizetős iOS appok és játékok, amik ingyenesek a mai napon...

MA 07:01

Egyre több kutatás bizonyítja, hogy az idősebb munkavállalók általában produktívabbak fiatalabb kollégáiknál...

MA 06:49

Kevesen mondanák azt, hogy az Nvidia részvénye olcsó, pedig valójában ez a helyzet...

MA 06:41

🕷 A tudósok feltárták azt a molekuláris titkot, amely a pókselymet acélnál erősebbé teszi, és új utakat nyit a jövő anyagai, valamint az agybetegségek megértése felé...

MA 06:32

A Fortune szerint az atomenergia újjászületése folyamatban van, ezúttal a mesterséges intelligencia energiaigényének kielégítésére...

MA 06:25

🏘️ Az ingatlanárak alakulásának megértéséhez kulcsfontosságú az aktív kínálat és a készlet hónapjainak figyelemmel kísérése...

MA 06:16

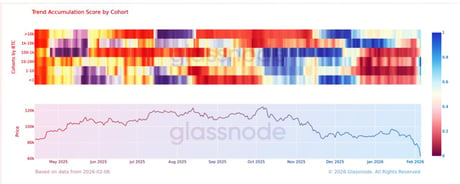

📈 A Glassnode adatai szerint február elején, amikor a bitcoin 29 millió forint körül forgott, a nagy befektetők elkezdtek pozíciót építeni...

MA 06:05

Mi történt ezen a napon a történelemben? Ezen a napon kivégzik Mary, Queen of Scots-ot (Skóciai Mária királynőt), Japán megszállja Szingapúrt, és elindul a NASDAQ tőzsdeindex...

MA 06:02

🔬 Egy úttörő klinikai vizsgálat kimutatta, hogy az MI-támogatott mammográfia több rákos megbetegedést képes felismerni, és korábban, mint a hagyományos vizsgálat...

szombat 20:37

🦠 Egy új kutatás megdöbbentő sebességet tárt fel, amivel a H1N1 és a COVID-19 elterjedt az amerikai városokban...

szombat 20:01

🚀 A Crew-12 űrhajósai február 11-én indulnak a Nemzetközi Űrállomásra, csatlakozva a fedélzeten maradt három űrutazóhoz, miután az előző missziót egészségügyi okokból lerövidítették...

szombat 19:55

Az egyik legnagyobb amerikai fizetésiátjáró-szolgáltató, a BridgePay ransomware-támadás áldozata lett, ami kulcsfontosságú rendszereit tette elérhetetlenné, és országos kiesést okozott...

szombat 19:37

💸 A Bitcoin 60 000 dollár közeléből körülbelül 69 000 dollárra tért magához, miután gyakorlatilag visszaadta azokat a nyereségeket, amelyeket Donald Trump 2024...

szombat 19:19

🏷️ Ebből következően érdemes megérteni, hogy február kellős közepén jócskán volt dolga az Engadget tesztelőinek...

szombat 19:02

Régészek angolszász gyerekeket fedeztek fel, akiket lándzsával, pajzzsal és csatokkal temettek el – olyan felszereléssel, amely általában harcosok sírjaiban található...